标签: 强化学习

标签: 强化学习

相关帖子

相关博文

-

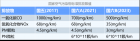

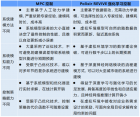

前不久,南大俞扬教授创办的公司编写了一本白皮书,总结了数据驱动强化学习在工业控制领域的应用经验,这项先进的人工智能技术已在化工、火电、水务等多个工业场景落地,这就证明强化学习智能决策可以实现“0试错”应用,实乃一大突破。 为什么说在工业领域的应用十分重要呢,首先是工业生产本身面临资源紧缺、能耗高、污染重、产品附加值低等问题,二则国家大力倡导各行各业数字化、智能化转型,三则工业领域的数字化、智能化转型是数字产业化的发展土壤。因此,人工智能技术在工业领域的落地必然受到关注。 数据驱动强化学习在实际业务场景中取得应用成效 《强化学习控制白皮书》中的数据驱动强化学习决策技术,与市场主流的监督学习和强化学习方式不同, 能真正从数据中回答“怎么做”的问题 。数据驱动强化学习突破了强化学习在应用过程中试错成本高、训练周期长等难题,迅速在实际业务中落地,解决传统工业控制中普遍面临的痛点,如: (1)多个环节由人工把控,依赖经验知识,不精准、不稳定且响应速度慢; (2)过程控制基于经典控制算法,难以满足大范围动态条件复杂系统的优化控制需求; (3)系统运维缺乏数据支撑,故障难预警、风险不可控。 以上流程控制中的不足,常造成企业 品质或产量不稳、生产线持续性不足、生产损耗过大、生产成本难以控制 等方面的问题。 此处列举一个运用数据驱动强化学习决策技术提升水系统增压泵房控制精度的案例, 更多关于高稳定策略、大滞后策略、全局策略的解决方案,见文末完整版白皮书: 增压泵房是给水系统中的重要组成部分,为城市供水管网提供所需的水量和压力,是整个供水系统中能耗组成的最大单元。传统人工控制靠操作人员经验,存在精度不足和非最优策略等问题,导致水量和能耗出现过高或过低等情况,影响供水系统的整体效率。人工控制的难点主要体现在: (1) 控制精度要求高 :当水务集团下发出水流量指令时,操作人员依据调控经验,始终无法突破 1000 吨水的调度精度,使出水总量波动大。 (2) 多个设备存在差异 :由于不同水泵的品牌和传感器老化程度不同,导致各水泵配水电耗和供给流量能力不同,人工难以精准感知,难以给出最优泵频组合。 实施过程: 第一步-根据增压泵房业务逻辑,在 Polixir REVIVE 中为每个水泵构建决策流图。 第二步-基于过去一年的泵频控制历史数据和决策流图,对每个水泵进行虚拟水泵控制环境构建。 第三步-根据目标流量、调节池水位和管网状态,在虚拟水泵控制环境中学习优化泵频控制策略。 第四步-控制策略线下验证。 POLIXIR REVIVE 此数据驱动强化学习工具打破了经典强化学习技术无法突破封闭环境的屏障,为技术人员提供一个训练环境模型(模拟器)和决策模型(模拟器)的工具,不用通过实时与现实环境交互的过程中试错,而是使用历史数据找到“决策最优解”后再用于现实。 市场上还有一中叫MPC(Model Predictive Control)的控制技术,它由两部分组成:系统模型用于预测未来状态,优化器用于基于未来状态求解最优控制。与 MPC 相似,REVIVE 强化学习控制首先学习虚拟环境模型(即系统模型),并基于虚拟环境求解最优控制策略。两者在结构上相似,但技术路线的不同带来诸多关键差异。 云边系统架构 基于REVIVE 得到的控制模型可载入到「ReinOptima 睿优」工业边缘控制器进行部署实施,另外 ReinOptima 还可同时加载 REVIVE 产生的虚拟环境模型,从而具备预测性维护的功能。 REVIVE 工业软件和 ReinOptima 工业边缘控制器通过云边协同架构可实现联动,当 ReinOptima 的预测性维护模块识别出系统发生偏移时,自动将 ReinOptima中的历史数据传到 REVIVE 系统,从而更新虚拟环境模型和控制策略,实现对环境变化的自动适应和持续的自我进化。 朋友们可通过 “点击头像-私信-留下邮箱” ,获得《强化学习控制白皮书》原文件。

-

背景:“国六”——新的标准和挑战 为进一步强化机动车污染防治,控制实际行驶过程中的排放,环境保护部、国家质检总局出台了 国六法规 , 规定所有汽车均应按照法规要求进行RDE试验。 国六,即“国家第六环节机动车辆空气污染物环保标准”,被分成“国六a”和“国六b”两个阶段,国六b将于2023年7月1日在全国各地统一执行。法规对一氧化碳、非甲乙烷、氮氧化合物及其PM可吸入颗粒物的排放标准益发严苛。 国六b比 国六 a更严 RDE:Real Driving Emission,实际道路排放 ,是指车辆在实际道路上行驶时的污染物排放。通过使用车载便携式排放设备PEMS(Portable Emission Measurement System)对所有车辆在实际道路行驶条件下进行排放测试。 RDE 实际道路排放试验 “国六b”法规规定 所有汽车均应按照法规附录测试要求进行RDE试验 ,试验结果市区行程和总行程污染物排放,均不得超过I型试验排放限值与规定的符合性因子(Conformity Factor,CF)的乘积,计算过程中不得采用四舍五入。 RDE试验带来的挑战: 1. 驾驶员行为(驾驶风格等)差异大; 2. 外部环境(温度、海拔等)不可控因素多; 3. 依靠人工经验难以覆盖各种变型配置项目; 4. 转毂测试条件较为单一,很难进行完整的验证与标定; 5. 试验占用资源多,费用昂贵、周期长、难度大。 解决方案 面对这些挑战,在确定了委托方需求之后 ,不依赖于已知的某种物理方程的专家模型,而是通过机器学习方法,应用自主研发数据驱动强化学习算法工具包「仙启」Revive,来构建与现实排放和动力学表现相符的虚拟模型。 这个方案旨在避免大量实车道路测试, 充分利用有限的资源,迅速适应不同车型(动力总成)的开发需求,快速找到最恶劣的RDE排放工况, 来证明车型是否可以满足RDE法规要求 相较传统方法,这个方案能够: 1. 更为完整地覆盖法规定义的RDE工况域, 避免大规模重复进行RDE试验 ; 2. 可进行 较长时间、可交互的整车动力学、气体排放等动态虚拟仿真 ; 3. 与实车的动力性能高度匹配, 工况表现能够在实际道路试验中成功复现 ; 4. 大大 降低整车在排放标定开发阶段的经济成本、时间成本以及人力成本 。 此外,它还提供了 法规约束边界库 ,可以按照法规要求的更新对约束条件进行调整。同时,还可以根据最新数据,对策略进行及时更新,以适应不断变化的真实业务场景。 案例和成果: 2022年,某汽车研发中心希望南栖仙策帮助缩短某款车型的研发周期,该方案大大降低了真实道路环境下的需要进行的测试次数,提高了动力系统的开发和验证效率。 在本案例中,我们导入的是RDE 5600 秒采数据: 秒采数据示意图 经过在 「仙启」 Revive中建模和训练,我们可以看到, Revive算法呈现的 虚拟仿真模型与真实环境的拟合的效果良好 。我们还与传统监督学习的行为克隆方式做了比较,通过对比, 能够更直观的看出,强化学习构建的 虚拟模型与真实动力学和道路排放的结果有多惊人 : 动力学模型: 车速模拟与真实数据对比(训练集) 发动机转速模拟与真实数据对比(训练集) 发动机扭矩模拟与真实数据对比(训练集) 车速模拟与真实数据对比(验证集) 发动机转速模拟与真实数据对比(验证集) 发动机扭矩模拟与真实数据对比(验证集) 排放模型: CO排放模拟与真实数据对比 CO2排放模拟与真实数据对比 NOX排放模拟与真实数据对比 PN排放模拟与真实数据对比 通过虚拟环境的构建和验证,我们可以看到,Revive基于强化学习的核心算法仿真的准确性,相比于行为克隆(一种基础监督学习技术),预测误差 显著 降低 。这得益于南栖仙策在 基础模型理论 和 因果泛化理论 上的学术突破,使得Revive 可以进行更长时间步的序列推演 ,从而使 虚拟仿真结果覆盖面更广,也更精确 。 在完成验证之后,接下来我们就可以在仿真环境中进行策略训练和优化,找到最恶劣的RDE排放工况,检查是否符合法规标准。 这是我们在本例中通过模型找到的最恶劣排放工况,可以看到,即便在如此恶劣的驾驶工况条件下,这款车型的动力和排放系统也可以满足法规要求。 动力学工况与法规约束 效果图 解读强化学习 : 人们对于强化学习的了解,或许还停留在AlphaGo名噪天下的时候,早期的强化学习虽频频取得超越人类的优秀表现,却只能局限在封闭环境。现在,强化学习正在从游戏环境走向实际的应用,与多学科交叉融合,一次次逼近极致,完成一项项看似不可能的任务。

-

在“双碳”大趋势下,燃油汽车亟需提高技术指标,以面对愈发严格的整车性能标准考核及市场份额的持续下滑趋势。标定是汽车研发的关键环节,直接影响汽车的技术指标,然而传统基于专家或模型的标定方法耗时长、成本高,并不能化解车企面临的困境,而新兴的AI技术可提供超越传统的高效解决方案。 强化学习AI智能决策应用者,在汽车标定业务上,将强化学习技术与汽车标定场景充分融合,摸索并总结出数据驱动的虚拟标定解决方案,旨在高效、高精度、低成本地完成标定业务。南栖仙策汽车交付团队基于强化学习研发的技术优势、服务汽车行业客户的经验,结合整车转鼓排放标定、混动标定两个实际案例,编写了《汽车虚拟标定白皮书》(以下简称为《白皮书》),展示了最新强化学习应用技术带来的AI能力,以及帮助汽车行业客户提升核心竞争力的潜力。 《白皮书》分为三部分进行阐述 第一部分:概述整车标定概念及车企面对的四大行业难题。 《白皮书》总结了汽车行业客户常面临的标定难题: 1.标定复杂度高,标定参数多达上千个。人工联合调优难,性能“将就”。 2.强烈依赖经验,需要经验丰富的工程师。人员易流失,经验随之带走。 3.试验成本高昂,物理实验开销难降低。研发成本难降低,挤压利润空间。 4.迭代周期冗长,需多次反复迭代试错。拖延产品发布,耽误市场时机。 除以上4点外,近两年受新冠疫情的影响,标定实测工作常常中断,严重影响了业务进展。 第二部分:介绍强化学习工具的不同与优势 全球领先的数据驱动强化学习工具REVIVE提供的数据模拟环境和强化学习优化可有助于解决车企面临的标定难题。REVIVE是面向行业专家的强化学习工具,通过数据驱动环境虚拟技术,进行大量虚拟推演与试错,寻找最优方案。 REVIVE基于汽车标定数据模拟环境的强化学习解决方案过程: REVIVE方案主要分为四步: 首先 在人工标定参数的实车验证实验中收集对应的性能状态秒采数据并进行简单的数据整理; 然后 根据汽车控制基础逻辑构建业务模型,导入数据,使用REVIVE系统中的环境模型训练功能,训练控制逻辑图中所有的神经网络模块,得到可运行的“数据仿真车”, 并使用可视化评估指标验证虚拟环境与真实环境的一致性; 再 使用REVIVE系统中的策略模型训练功能,得到优化后的标定参数; 最后 将优化后的标定参数在虚拟环境中验证,评估有效则上载到汽车进行 实车验证。 图为:REVIVE基于数据模拟环境的强化学习解决方案过程 第三部分:结合发动机整车排放标定、混动标定两个案例,介绍REVIVE成功应用方案。 《白皮书》实例证明,独特的AI虚拟标定技术可显著降低汽车尾气排放值。与人类工程师相比,THC降低了51%,CO降低了29%,NOx降低了18%,优于国六排放标准,并为后续车辆设计环节提供了充足的排放余量。 在串并联混动系统标定任务上同样成功。在起点—终点电量相同的约束下,能优化得到更合理的利用电池电量容量、更高效的利用发动机最优工况特性的混动策略,使得整车在WLTC实验中取得更低的油耗。 朋友们可通过“点击头像-私信-留下邮箱”获得 《汽车虚拟标定白皮书》 原文件。

-

前不久,南大俞扬教授创办的公司编写了一本白皮书,总结了数据驱动强化学习在工业控制领域的应用经验,这项先进的人工智能技术已在化工、火电、水务等多个工业场景落地,这就证明强化学习智能决策可以实现“0试错”应用,实乃一大突破。 为什么说在工业领域的应用十分重要呢,首先是工业生产本身面临资源紧缺、能耗高、污染重、产品附加值低等问题,二则国家大力倡导各行各业数字化、智能化转型,三则工业领域的数字化、智能化转型是数字产业化的发展土壤。因此,人工智能技术在工业领域的落地必然受到关注。 数据驱动强化学习在实际业务场景中取得应用成效 《强化学习控制白皮书》中的数据驱动强化学习决策技术,与市场主流的监督学习和强化学习方式不同, 能真正从数据中回答“怎么做”的问题 。数据驱动强化学习突破了强化学习在应用过程中试错成本高、训练周期长等难题,迅速在实际业务中落地,解决传统工业控制中普遍面临的痛点,如: (1)多个环节由人工把控,依赖经验知识,不精准、不稳定且响应速度慢; (2)过程控制基于经典控制算法,难以满足大范围动态条件复杂系统的优化控制需求; (3)系统运维缺乏数据支撑,故障难预警、风险不可控。 以上流程控制中的不足,常造成企业 品质或产量不稳、生产线持续性不足、生产损耗过大、生产成本难以控制 等方面的问题。 此处列举一个运用数据驱动强化学习决策技术提升水系统增压泵房控制精度的案例, 更多关于高稳定策略、大滞后策略、全局策略的解决方案,见文末完整版白皮书: 增压泵房是给水系统中的重要组成部分,为城市供水管网提供所需的水量和压力,是整个供水系统中能耗组成的最大单元。传统人工控制靠操作人员经验,存在精度不足和非最优策略等问题,导致水量和能耗出现过高或过低等情况,影响供水系统的整体效率。人工控制的难点主要体现在: (1) 控制精度要求高 :当水务集团下发出水流量指令时,操作人员依据调控经验,始终无法突破 1000 吨水的调度精度,使出水总量波动大。 (2) 多个设备存在差异 :由于不同水泵的品牌和传感器老化程度不同,导致各水泵配水电耗和供给流量能力不同,人工难以精准感知,难以给出最优泵频组合。 实施过程: 第一步-根据增压泵房业务逻辑,在 Polixir REVIVE 中为每个水泵构建决策流图。 第二步-基于过去一年的泵频控制历史数据和决策流图,对每个水泵进行虚拟水泵控制环境构建。 第三步-根据目标流量、调节池水位和管网状态,在虚拟水泵控制环境中学习优化泵频控制策略。 第四步-控制策略线下验证。 POLIXIR REVIVE 此数据驱动强化学习工具打破了经典强化学习技术无法突破封闭环境的屏障,为技术人员提供一个训练环境模型(模拟器)和决策模型(模拟器)的工具,不用通过实时与现实环境交互的过程中试错,而是使用历史数据找到“决策最优解”后再用于现实。 市场上还有一中叫MPC(Model Predictive Control)的控制技术,它由两部分组成:系统模型用于预测未来状态,优化器用于基于未来状态求解最优控制。与 MPC 相似,REVIVE 强化学习控制首先学习虚拟环境模型(即系统模型),并基于虚拟环境求解最优控制策略。两者在结构上相似,但技术路线的不同带来诸多关键差异。 云边系统架构 基于REVIVE 得到的控制模型可载入到「ReinOptima 睿优」工业边缘控制器进行部署实施,另外 ReinOptima 还可同时加载 REVIVE 产生的虚拟环境模型,从而具备预测性维护的功能。 REVIVE 工业软件和 ReinOptima 工业边缘控制器通过云边协同架构可实现联动,当 ReinOptima 的预测性维护模块识别出系统发生偏移时,自动将 ReinOptima中的历史数据传到 REVIVE 系统,从而更新虚拟环境模型和控制策略,实现对环境变化的自动适应和持续的自我进化。 朋友们可通过 “点击头像-私信-留下邮箱” ,获得《强化学习控制白皮书》原文件。

相关资源

-

MATLABEXPO2019深度学习与强化学习——MATLAB人工智能算法开发By马文辉

-

针对现有基于强化学习的云资源调度算法收敛速度慢的问题,在详细分析云作业执行流程后,采用了一种细粒度的云计算平台模型,设计了一种基于高斯过程回归和强化学习的云计算资源调度算法。算法将资源分配问题转换为在服务等级协议约束下的资源分配最小化问题,并通过高斯过程回归加速最优策略的生成。在CloudSim平台下进行了仿真,实验结果证明了本文算法在一定程度上加速了最优策略的收敛。

-

解决拥有连续状态空间以及模型未知的倒立摆系统长久以来是个难题。文章将强化学习(ReinforcementLearning)与神经网络(ELM网络和BP网络)相融合,运用神经网络的抽象和泛化能力,采用Actor-Critic架构,提出基于ELM-BP的强化学习倒立摆控制方法。针对连续空间,BP充当动作网络,根据输入的状态映射出要执行的动作,ELM也叫极速学习机充当评价网络近似逼近函数值,输出评价。同时为了降低样本空间大小提高收敛速度,引入滚动时间窗机制和适合度轨迹。经过训练和学习,能够有效解决具有连续状态空间的倒立摆系统的问题。通过Matlab软件仿真模拟倒立摆的环境进行实验,运用提出的新方法进行控制,在衡量倒立摆算法的几个指标上(尝试次数,所需时间,角度最大绝对值,位移最大绝对值等)均得到了良好的效果。