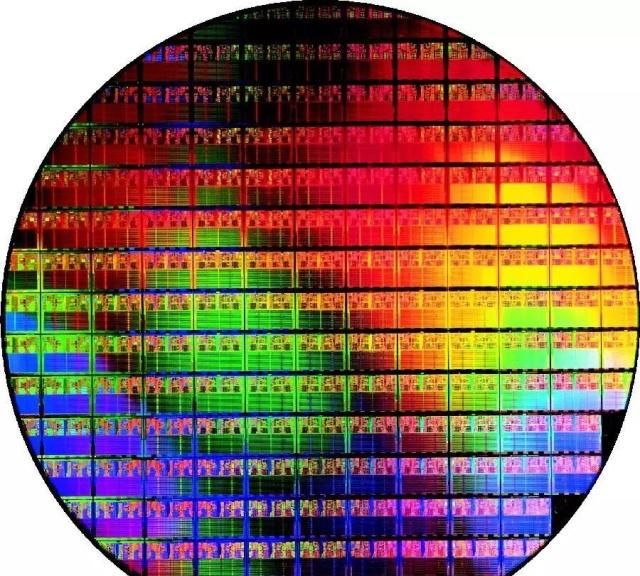

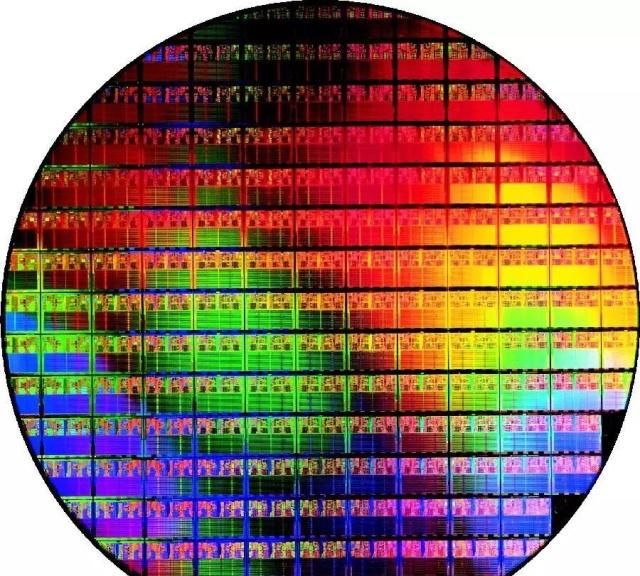

ISU教授疯狂实验:搭建40个GPU晶圆级计算机比40台基于GPU的服务器更牛的是什么?一台有40个GPU的服务器!伊利诺伊州立大学计算机工程副教授及其团队将于2月,为包含多达40个GPU的晶圆级计算机提供案例。这个多处理器“怪物”将计算速度提高了近19倍,并将能耗和信号延迟的总和降低了140倍以上。搭载40个GPU的服务器,就问你怕不怕!早在20世纪80年代,并行计算先驱Gene Amdahl就策划了一项加速大型机计算的计划:一种硅晶片大小的处理器。通过将大部分数据保存在处理器本身,而不是将其通过电路板传输到内存和其他芯片上,计算速度会更快,能源效率也会更高。Amdahl从风投那里获得了2.3亿美元的投资,这在当时是最多的。而后他创立了Trilogy Systems公司,将自己的梦想变成了现实。这是“晶圆级集成”的首次商业尝试,结果成了一场灾难。 伊利诺伊大学厄巴纳-香槟分校和加州大学洛杉矶分校的工程师们认为,现在是时候再尝试一次了。在2月即将举行的IEEE高性能计算机体系结构国际研讨会上,伊利诺伊州立大学计算机工程副教授Rakesh Kumar及其合将为包含多达40个GPU的晶圆级计算机提供案例。这个多处理器“怪物”将计算速度提高了近19倍,并将能耗和信号延迟的总和降低了140倍以上。Kumar表示:“我们试图解决的一个大问题是计算单元之间的通信开销。”基于保证质量的普通尺寸芯片,寻找连接技术是关键超级计算机通常将应用程序分布在数百个GPU上,这些GPU位于不同的印刷电路板上,并通过长途数据链路进行通信。与芯片本身内部的互连相比,这些链路吸收能量并且速度慢。 更重要的是,由于芯片和印刷电路板的机械特性之间不匹配,处理器必须保存在严格限制其可以使用的输入和输出数量的封装中。因此,将数据从一个GPU转移到另一个GPU需要大量的开销。所需要的是GPU模块之间的连接,这些连接与芯片上的互连一样快,低能耗且丰富。如此快速的连接将把这40个GPU集成到一起,成为一个巨大的GPU。一种解决方案是:使用标准的芯片制造技术在同一块硅片上构建所有40个GPU,并在它们之间添加互连。但正是这种思路扼杀了Amdahl在20世纪80年代的尝试。当你在制作一个芯片时,总是有出现缺陷的可能性,而出现缺陷的可能性会随着芯片的大小而增加。如果你的芯片大小与餐盘一样大小,几乎可以保证在它上面有一个系统“杀戮”的缺陷。因此,从已经通过质量测试的普通尺寸的GPU芯片开始,寻找一种更好地连接它们的技术,是更有意义的。这个团队相信他们的silicon interconnect fabric(SiIF)的技术,用硅代替电路板,芯片与电路板之间没有机械上的不匹配,因此不需要芯片封装。

伊利诺伊大学厄巴纳-香槟分校和加州大学洛杉矶分校的工程师们认为,现在是时候再尝试一次了。在2月即将举行的IEEE高性能计算机体系结构国际研讨会上,伊利诺伊州立大学计算机工程副教授Rakesh Kumar及其合将为包含多达40个GPU的晶圆级计算机提供案例。这个多处理器“怪物”将计算速度提高了近19倍,并将能耗和信号延迟的总和降低了140倍以上。Kumar表示:“我们试图解决的一个大问题是计算单元之间的通信开销。”基于保证质量的普通尺寸芯片,寻找连接技术是关键超级计算机通常将应用程序分布在数百个GPU上,这些GPU位于不同的印刷电路板上,并通过长途数据链路进行通信。与芯片本身内部的互连相比,这些链路吸收能量并且速度慢。 更重要的是,由于芯片和印刷电路板的机械特性之间不匹配,处理器必须保存在严格限制其可以使用的输入和输出数量的封装中。因此,将数据从一个GPU转移到另一个GPU需要大量的开销。所需要的是GPU模块之间的连接,这些连接与芯片上的互连一样快,低能耗且丰富。如此快速的连接将把这40个GPU集成到一起,成为一个巨大的GPU。一种解决方案是:使用标准的芯片制造技术在同一块硅片上构建所有40个GPU,并在它们之间添加互连。但正是这种思路扼杀了Amdahl在20世纪80年代的尝试。当你在制作一个芯片时,总是有出现缺陷的可能性,而出现缺陷的可能性会随着芯片的大小而增加。如果你的芯片大小与餐盘一样大小,几乎可以保证在它上面有一个系统“杀戮”的缺陷。因此,从已经通过质量测试的普通尺寸的GPU芯片开始,寻找一种更好地连接它们的技术,是更有意义的。这个团队相信他们的silicon interconnect fabric(SiIF)的技术,用硅代替电路板,芯片与电路板之间没有机械上的不匹配,因此不需要芯片封装。 SiIF晶圆上有一层或多层2微米宽的铜互连,间距最小可达4微米。这相当于芯片上最高级别的互连。在要插入GPU的点中,硅片上的铜柱间距约为5微米。GPU在这些上方对齐,按下并加热。这种成熟的工艺称为热压结合(thermal compression bonding),使铜柱与GPU的铜互连线融合。伊利诺斯州和加州大学洛杉矶分校的研究人员表示,窄小的互连和紧密的间距意味着你可以在一块芯片上压缩至少25倍的输入和输出。Kumar和他的同事在设计晶圆级GPU时,必须考虑许多限制因素,包括可以从晶圆上移除多少热量、晶圆处理器如何能够最快速地相互通信,以及如何在整个晶圆上传输电力。

SiIF晶圆上有一层或多层2微米宽的铜互连,间距最小可达4微米。这相当于芯片上最高级别的互连。在要插入GPU的点中,硅片上的铜柱间距约为5微米。GPU在这些上方对齐,按下并加热。这种成熟的工艺称为热压结合(thermal compression bonding),使铜柱与GPU的铜互连线融合。伊利诺斯州和加州大学洛杉矶分校的研究人员表示,窄小的互连和紧密的间距意味着你可以在一块芯片上压缩至少25倍的输入和输出。Kumar和他的同事在设计晶圆级GPU时,必须考虑许多限制因素,包括可以从晶圆上移除多少热量、晶圆处理器如何能够最快速地相互通信,以及如何在整个晶圆上传输电力。

关闭

站长推荐

/2

/2

/2

/2

文章评论(0条评论)

登录后参与讨论