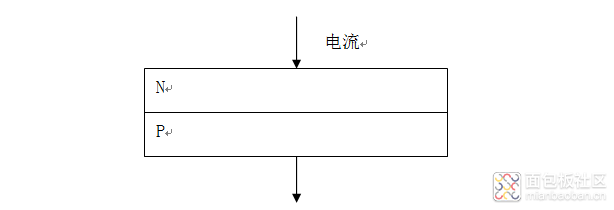

二极管就是把一个N型半导体和P型半导体叠放一起,N型P型是向半导体中掺入了不同的杂质,由于N型、P型半导体的导电特性,在二极管的电路中电流只能由N极向P极单向导通。

在电路里,二极管作为基础器件的原理就是用于“整流”,将交流电转为直流电(生活中电网上的电都是交流的,所以无论什么电器都必须带个电源模块将交流电转为直流使用),而且实现了单向导通,所谓指哪打哪,有了二极管工程师们才可以发挥他们的聪明才智将电流导向需要的地方实现各种复杂的功能。

发光二极管将P极和N极链接的部分做一些特殊处理,我们可以称之为发光层,当电子从N极进入P极时,电子在发光层产生能阶的降低从而释放出能量,这种能量以光子的形式释放就形成了可见光。

发光二极管的发光亮度与单位时间内通过的电子数量有关,通过的电子数量越多释放的能量就越大从而产生“更亮”的光。但是电子太多,电流太大会“击穿”二极管,一般的工作电流在5mA至20mA,电流太小灯不亮,太大就会烧坏。发光二极管的自带电阻很小,在一般使用中我们可以认为其电阻为0,所以直接向二极管两端加电压会导致烧坏。这也就是为啥会在二极管电路中加上一个电阻,阻值一般是300欧姆左右。如果是5V的电压,可算得电流是16mA,3V的电压算得的电流是10mA。

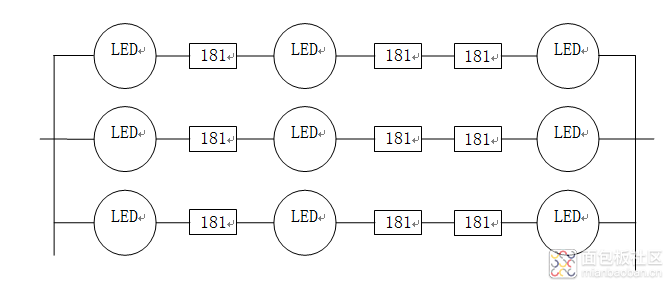

那么我们现在随便买一个商用的LED灯带,仔细看的话会发现一组灯珠会有3个181欧姆的电阻,一条灯带一般有20组灯珠。在结构上,一组灯珠内的LED灯是串联的,但整体结构又是并联的20组灯珠。

计算可得并联电路中单路的电流是24mA(这种商用的5050LED一般电流小于60mA都没问题),总路电流为24mA*20=480mA(并联电路中并联的电阻越多,总电阻越小)。从这个例子中也可以看出为啥家用电器不能太多,家用电路通过插口接入的都是并联电路,接入的电器越多总电阻反而越小,总电流越来越大,最后电流超过电线的承载能力导致短路。

作者: 布兰姥爷, 来源:面包板社区

链接: https://mbb.eet-china.com/blog/uid-me-3887969.html

版权声明:本文为博主原创,未经本人允许,禁止转载!

晓哦 2020-12-1 19:58

CationLiu 2019-3-28 13:25

法师 2019-3-23 15:28

易晓 2019-3-23 10:21

你个糟老头子坏得很!

CationLiu 2019-3-22 12:29

用户3884215 2019-3-19 16:58

443955496_148404734 2019-3-15 15:19

eeNick 2019-3-15 15:07

eyesee00 2019-3-15 11:30