在计时过程中,系统利用89C51自身的计时器T0作为时钟基准,计时器中断的准确度直接关系到整个系统的精度,因此获取精确的定时时钟信号成为该系统的关键。MCS-51单片机内有2个可编程的16位定时器/计数器,在本系统设计中采用AT89C51的定时器T0,并工作在方式l下,晶振频率为12MHz。

1 T0定时中断

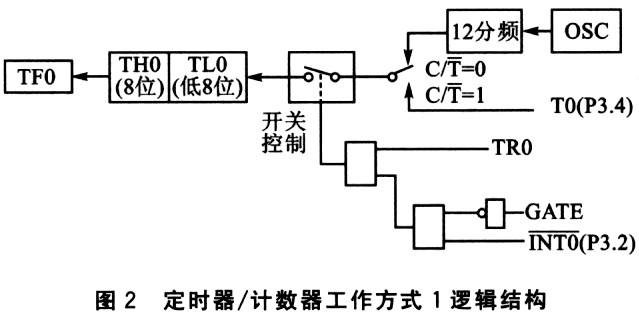

定时器/计数器T0工作方式1的电路逻辑结构如图2所示。TO定时特性功能寄存器由TL0(低8位)和TH0(高8位)构成。特殊功能寄存器TMOD控制定时寄存器的工作方式;TCON则用于控制定时器T0和T1的启动和停止计数,同时管理定时器TO和T1的溢出标志等。程序开始时需对TL0和TH0进行初始化编程,以定义它们的工作方式,并控制T0和T1的计数。在系统的设计中,计时单位以s为基准,并要求日误差≤10 s,如果用循环去做,无法满足精度要求。选用12 MHz的晶体可得到lμs的精度,经分析确定使用定时器0的方式l。这个方式下 定时器0是16位定时器,也就是最大定时值为jFFFFH,12 MHz晶体的每个定时周期为1 μs,最多可以定时FFFFH×1 μs=65635 μs,即使使用最大值也无法一次定时1 s,设计中使用1次定时20 ms,50次定时中断得到1 s。20 ms定时中断的定时值为:FFFFH-20 ms/l μs=B1DFH[1].

2 程序测试与调整

在Keil uVision3平台下利用C语言实现如下代码:

#include<reg52.h>

#define uehar unsigned char

uehar data MScond="0"; //ms

uchar data Scond="0"; //s

uchar data Minure="0"; //rain

uchar data Hollr="0"; //h

void main(void){

EA=1; //允许CPU中断

ET0=1; //定时器0中断打开

TMOD=0xl; //设定时器0为方式1

TH0=0xBl:

TL0=0xDF~ //设定时值为20 000 μs(20 ms)

TR0=1; //开始定时

while(1);

}

void Time0(void)interrupt 1 using 1

{TH0=0xBl; //20 ms断点 (1)

TL0=0xDF; //设定时值

MScond=MScond+1 ;

if(MScond==50)

{MScond=0;

Scond=Scond+1;

if(Seond==60)

{Scond=0;

Minute=Minute+1; //分断点 (2)

if(Minute==60)

{Minute=0;

Hour=Hour+1; //d,时断点 (3)

if(Hour==24)

{Hour=0;}}}}

首先调试每20 ms中断时的精度,在选项中设定调试晶振为12 MHz,在(1)处设置一个断点再运行,这时记录下每次中断时的时间,如图3所示。在初始化中费时为551 μs,每一次中断时间应该考虑该项的影响。在实际处理中可以利用两次中断时间的差来作为定时器的中断时间间隔。

通过测试,得到第一次为0.020 568 00 s,第二次为0.040 580 00 s,第三次为0.060 59Z 00 s。可以看出,每中断一次会比定时值长了12 μs。如果将断点设定在(2)处,并通过Logic Analyzer tool,得到分钟第一次中断的时间为60.036 57 s,第二次中断的时间为120.072 57 s,则每分钟的实际时间为60.036 s。再将断点设定在(3)处,得到小时第一次中断的时间为3 602.160 576 s,第二次中断的时间为7 204.320 576 s,可以得到小时的实际时间为3 602.16 s,如图4所示。

为什么会产生这些误差呢?通过对中断程序的汇编源码进行分析,实际上中断程序入堆栈时使用了两条语句:PUSH ACC和PUSH PSW。执行人栈指令花费了4个机器周期,加上重新对TH0和TL0的加载又用去2个机器周期,计数值加1花费了2个机器周期,中断返回约4个机器周期共约12个机器周期。为了消除这些因素的影响,需要在对T0设置计数值时减去12个机器周期,将计算得到的初始值B1DFH加上12(0CH)得到:B1DFH+12=B1EBH作为新的定时器初值,修改后的程序为:

#include<reg52.h>

#define uchar unsigned char

uchar data MScond="0";//ms

uehar data Seond="0"; //s

uchar data Minute:0; //rain

uchar data Hour="0"; //h

void main(void){

EA=1; //允许CPU中断

ET0=1; //定时器0中断打开

TMOD=Oxl; //设定时器0为方式1

TH0=0xBl;

TL0=OxEB; //设定时值为20 000 μs(20 ms)减去12 μs

TR0=1; //开始定时

while(1);

void Time0(void)interrupt 1 using 1

{TH0=0xBl; //20 ms断点 (1)

TL0=0xDF‘ //设定时值

MSeond=MScond+1:

if(MSeond==50)

{MScond=0;

Seond=Seond+1 ;

if(Scond==60)

{Scond=0;

Minute=Minute+1;//分断点 (2)

if(Minute==60)

{Minure=0;

Hour=Hour+1; I/d,时断点 (3)

if(Hour==24)

{Hour=0;}}}}

重新调试程序,仍然在选项中设定调试晶振为12 MHz,重新测试20 ms定时器的实际时间,在(1)处设置一个断点后运行,重新记录下每次中断时的时间,如图5所示。初始化时间为556 μs,为消除其影响,使用两次中断时间间隔来作为定时器实际获得的基准时钟。

得到第一次中断时的时间为0.020 556。O s,第二次为O.040 556 000 s,第三次为0.060 556。O s,可以看出每次中断间隔刚好20 ms。如果将断点设定在(2)处,并通过Logle Analyzer tool,得到第一次中断时时间为60.000 57 s,第二次为120.000 57 s,间隔刚好60 s。将断点设定在(3)处,得到第一次中断的时间为3 600.000 578 s,第二次中断时间为7 200.000 578 s,时间间隔为3 600 s,测试结果如图6所示,完全可以满足系统设计的需要。

3 总结

通过对定时器的误差分析和校正,可以提高系统的精确度。当然,上面的分析是在软环境下理想晶振频率下实现的,在现实中会因晶振偏差等因素而造成误差[2]。在该测试中,主程序没有进行其他处理,而在日历设计中还要涉及到计时器T1的中断来完成对扫描显示电路的处理,还包括外部中断对时钟进行了调整,加上一些闹钟功能,这必然会对T0的定时精确性产生影响。另外,当中断程序中语句越多,占用的机器周期也越多,因此在设计中应充分利用Keil uVIsion3的分析工具,通过多次调整计数初值以获取精确的时钟信号,这对于要求精确时钟信号的应用具有重要的意义。

/4

/4

文章评论(0条评论)

登录后参与讨论