一,问题来源:

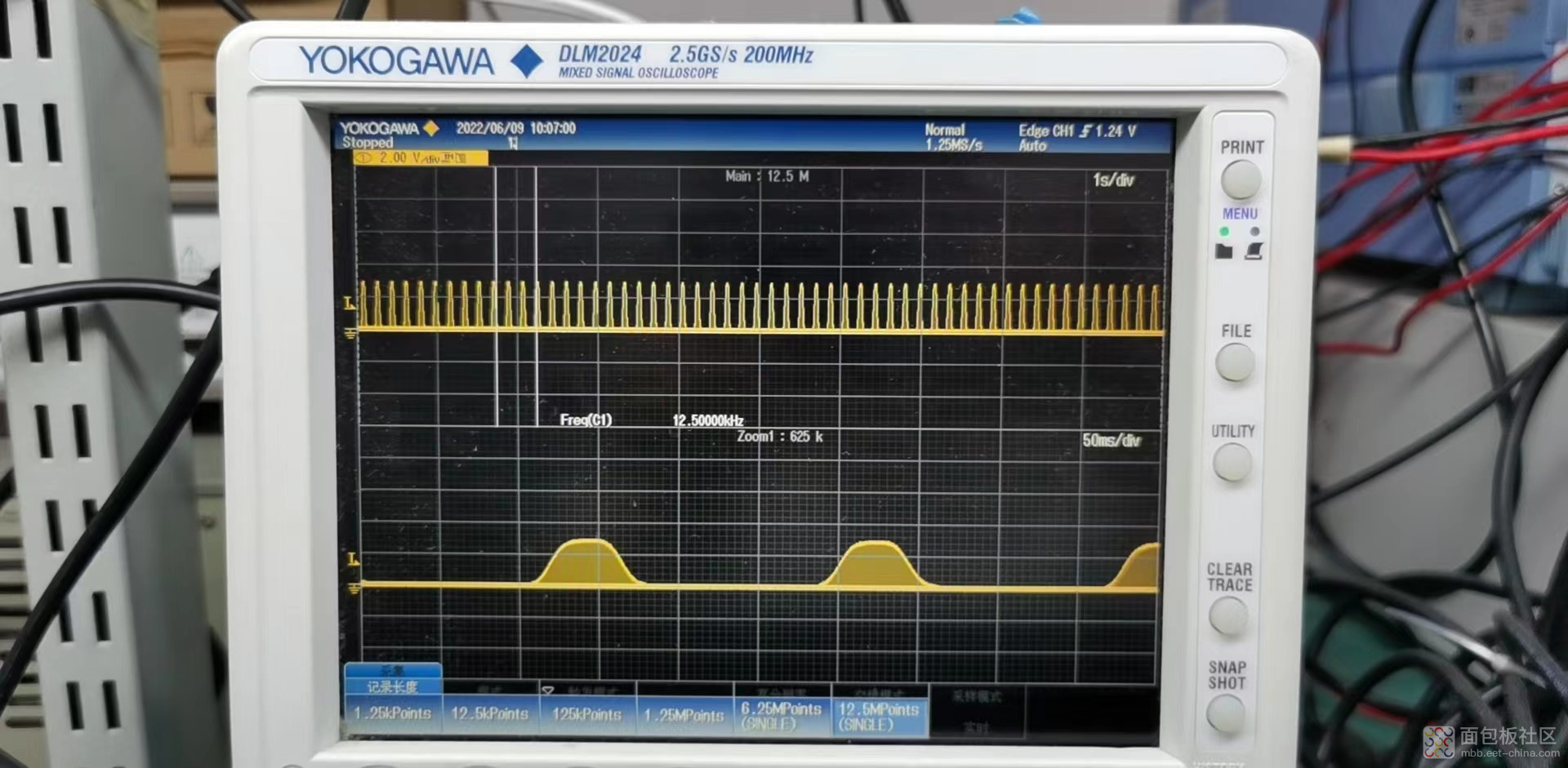

1,示波器采样率是2.5GS/s(Gpoints/s), 示波器满屏显示为10s ,存储深度12.5MPoints,测量信号脉冲波频率 100Khz, duty 1% ,Ton=100nS,波形完全失真。

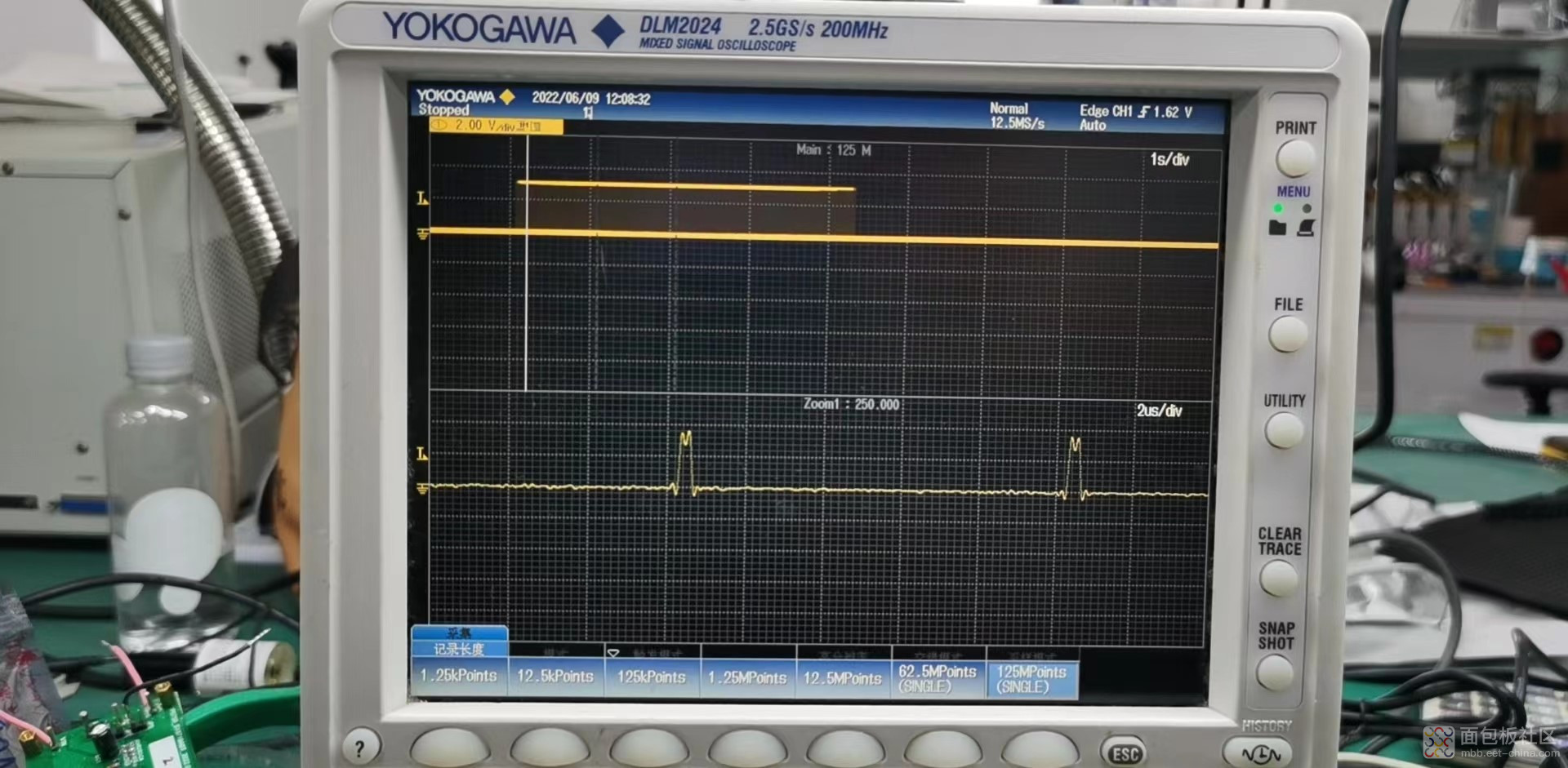

2,示波器采样率是2.5GS/s, 示波器满屏显示为10s ,存储深度125MPoints,测量信号脉冲波频率 100Khz, duty 1% ,Ton=100nS,波形部分失真。

二,问题原因:

基础公式:存储深度=采样率*采样时间

示波器存储深度12.5Mpoints(12.5MS), 实际采样率=12.5Mpoints/10S=1.25Mpoints/s=1.25points/us。

示波器存储深度最大125Mpoints(125MS), 实际采样率=125Mpoints/10S=12.5Mpoints/s=12.5points/us。

测量信号脉冲波频率 100Khz, duty 1% ,Ton=100nS,设100nS要抓10个点比较清晰,每个点间隔10ns,10s/10ns=1Gpoints存储深度才够。

参考资料:示波器入门之采样率、存储深度_Dufre.WC的博客-CSDN博客_存储深度与采样率关系

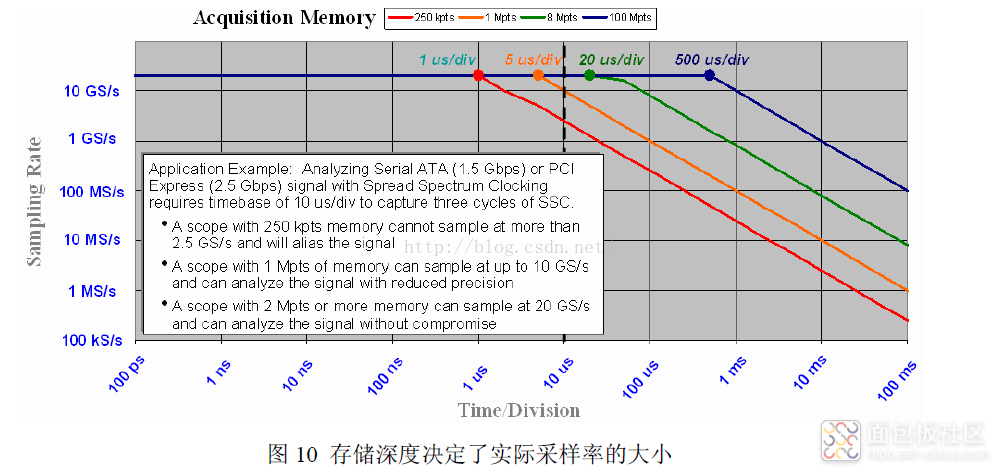

下图的曲线充分揭示了采样率、存储深度、采样时间三者的关系及存储深度对示波器实际采样率的影响。比如,当时基选择10us/div档位时,整个示波器窗口的采样时间是10us/div * 10格=100us,在1Mpts的存储深度下,当前的实际采样率为:1M÷100us=10Gs/s,如果存储深度只有250K,那当前的实际采样率就只有2.5GS/s了!

作者: 黎查, 来源:面包板社区

链接: https://mbb.eet-china.com/blog/uid-me-397261.html

版权声明:本文为博主原创,未经本人允许,禁止转载!

/1

/1

文章评论(0条评论)

登录后参与讨论