AI 模型数据量和算力需求大。美光首席商务官萨达纳表示,一个典型的人工智能服务器的 DRAM 容量是普通服务器的 8 倍,NAND 容量是普通服务器的 3 倍。GPT3 相较 GPT2 在数据存储端从 百 G 提升至 40T,在存储量上有约 100 倍的提升,算力需求同样也呈几何倍增长。据 Open AI 测 算,2012 年以来全球头部 AI 模型训练算力需求 3-4 个月翻一番,每年头部训练模型所需算力增 长幅度高达 10 倍,远超摩尔定律的增长速度,而大容量存储是大算力数据稳定运算的重要基础。 随着算力的不断进步,所需存储的数据量在以指数级的增长速度攀升,数据激增将刺激存储芯片 需求逐年上升。得益于人工智能、物联网、云计算、边缘计算等新兴技术在中国的快速发展,中 国数据正在快速增长。据此前 IDC 预测,预计到 2025 年,中国数据圈将增长至 48.6ZB,占全球 数据圈的 27.8%,成为全球最大的数据圈。

内存技术同步 AI 需求升级。内存接口芯片是高端服务器中 CPU 与内存之间进行数据传输的核心 部件,其主要作用是提升高速内存数据访问的速度及稳定性,满足服务器 CPU 对内存模组日益增 长的高性能及大容量需求。为提升服务器性能,AI 服务器需搭载多个 CPU 和 GPU 处理器,同时 服务器 CPU 性能不断升级,要求内存技术同步升级。DDR5、HBM、CXL、NVLink 等技术将加 速渗透,有望充分受益于 AI 带来的算力需求增长。

DDR5 对比 DDR4 性能全面提升,需要使用更多内存接口芯片。1)性能:DDR5 内存频率从 3200MHz 起跳(一般都会在 4800MHz 以上)、最高可达 8400MHz;2)核心容量密度:SK 海 力士给出 8Gb、16Gb、24Gb、32Gb、64Gb 丰富的选择, DDR5 单条内存最大可到 128GB;3) 功耗:DDR5 支持 1.1V 电压,进一步降低了功耗。另外,DDR5 搭载 DQS 间隔振荡器,具备错 误检查与清理能力,具备更强的抵抗环境变化的能力和更强的可靠性。DDR5 性能全面提升,要 求新一代内存接口芯片支持高速、低功耗、系统扩展等要求。DDR5 模组需要搭载 SPD、电源管 理芯片(PMIC)和温度传感器(TS)等配套芯片。此外,在 LRDIMM 模组中,相比 DDR3 只采 用 1 颗寄存缓存芯片、DDR4 最多采用“1+9”个内存芯片,DDR5 对内存接口的需求进一步提 升,最多达到“1+10”个(1RCD+10DB),内存接口芯片有望迎来量价齐升。

HBM 为大算力芯片提供支撑。ChatGPT 依赖更高算力,且更多是趋向于矩阵类和卷积类的计算, 其对内存的需求也体现在训练和推理 AI 芯片,或是加速模块里的内存带宽,而 HBM 是一种基于 3D 堆叠工艺的 DRAM 内存芯片,被安装在 GPU、网络交换设备、AI 加速器及高效能服务器上。 HBM 能大幅提高数据处理速度,每瓦带宽比 GDDR5 高出 3 倍还多,且 HBM 比 GDDR5 节省了 94%的表面积。HBM 作为一种带宽远超 DDR/GDDR 的高速内存,将为大算力芯片提供能力支撑, 同时生成类模型也会加速 HBM 内存进一步增大容量和增大带宽。TrendForce 预估 2023-2025 年 HBM 市场年复合成长率有望成长至 40-45%以上。

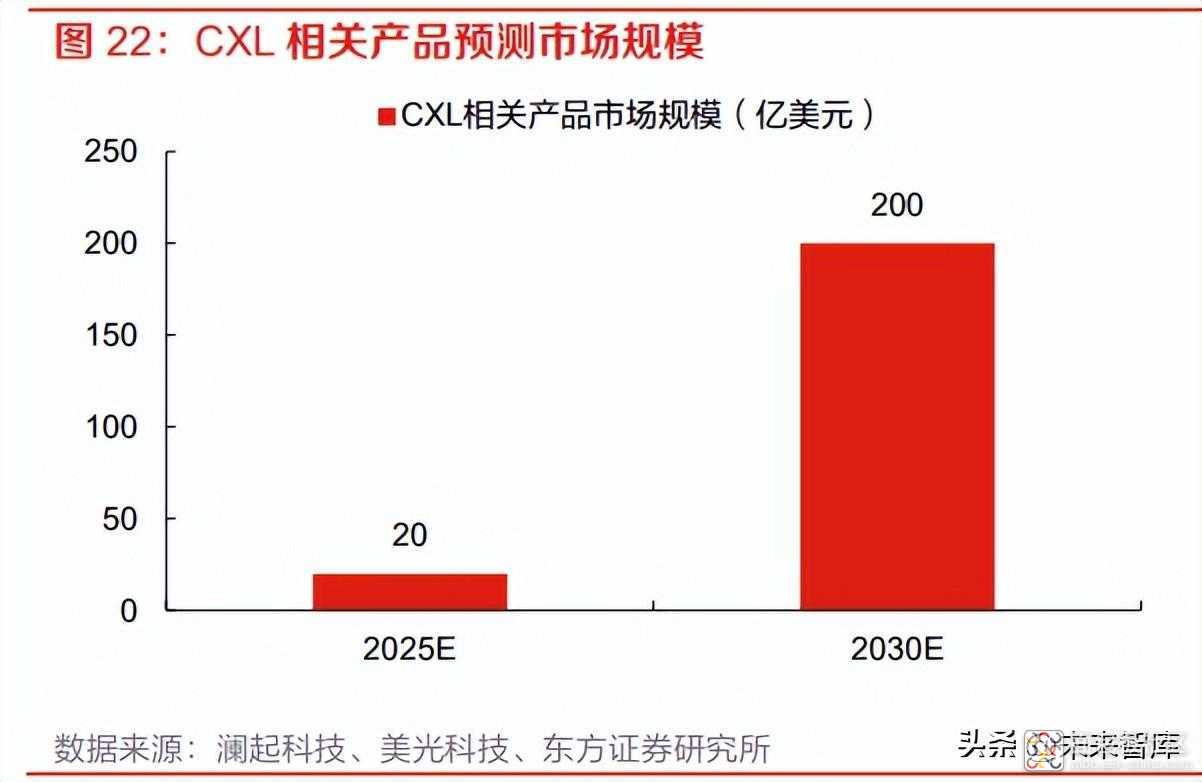

CXL 兼容性强、可实现内存一致性。CXL 全称为 Compute Express Link,是由英特尔于 2019 年 3 月在 Interconnect Day 2019 上推出的一种开放性互联协议,能够让 CPU 与 GPU、FPGA 或其 他加速器之间实现高速高效的互联,从而满足高性能异构计算的要求。在AMD、ARM、IBM以及 英特尔四个主要 CPU 相关供应商的支持下,CXL 已经成为领先的行业标准。CXL 构建于 PCI-e 逻辑和物理层级之上,所以其兼容性很高,更容易被现有支持 PCI-e 端口的处理器(绝大部分的 通用 CPU、GPU 和 FPGA)所接纳,同时 CXL 可在 CPU,以及 GPU、FPGA 等之间建立高速 且低延迟的互连,维护 CPU 内存空间和连接设备上的内存之间的内存一致性,允许 CPU 与 GPU 之间绕过 PCIe 协议,用 CXL 协议来共享、互取对方的内存资源,从而大幅提升数据运算效率。 CXL 有望在未来的服务器中以有效和可扩展的方式增加内存、容量和带宽,成为 ChatGPT 等 AI 应用的重要配合性技术。美光科技在 22 年 5 月预测 CXL 相关产品的市场规模,到 2025 年预计将 达到 20 亿美金,到 2030 年可能超过 200 亿美金。

NVLink 可最大化提升系统吞吐量。AI 和 HPC(包括新兴的万亿参数模型)领域的计算需求不断 增长,在这一趋势的推动下,对于能够在每个 GPU 之间实现无缝高速通信的多节点、多 GPU 系 统的需求也在与日俱增。要打造功能强大且能够满足业务速度需求的端到端计算平台,可扩展的 快速互连必不可少。第四代 NVIDIA® NVLink®技术可为多 GPU 系统配置提供高于以往 1.5 倍的带 宽,以及增强的可扩展性。单个 NVIDIA H100 Tensor Core GPU 支持多达 18 个 NVLink 连接, 总带宽为 900GB/s,是 PCIe 5.0 带宽的 7 倍。第三代 NVIDIA NVSwitch™基于 NVLink 的高级通 信能力构建,可为计算密集型工作负载提供更高带宽和更低延迟。为了支持高速集合运算,每个 NVSwitch 都有 64 个 NVLink 端口,并配有 NVIDIA SHARP™引擎,可用于网络内归约和组播加 速。通过在服务器外部添加第二层 NVSwitch,NVLink 网络可以连接多达 256 个 GPU,并提供57.6 TB/s 的惊人多对多带宽,从而快速完成大型 AI 作业。NVIDIA DGX™ H100 等服务器可利 用 NVLink 技术来提高可扩展性,进而实现超快速的深度学习训练。

/5

/5