引入触摸控制

工业物联网(IIoT)实现了制造和智能机器通信的自动化,但仍有一些时候人类必须与机器交互。为了减少细菌和病毒的传播,我们需要传统按钮或触摸屏控制的非接触式替代品。

工业物联网(IIoT)实现了制造和智能机器通信的自动化,但仍有一些时候人类必须与机器交互。为了减少细菌和病毒的传播,我们需要传统按钮或触摸屏控制的非接触式替代品。

许多用户都熟悉家庭或车辆中的语音助手应用。然而,这种类型的语音控制在嘈杂的生产设施、活跃的户外环境或说话的人群中是不可靠的。对于这些情况,可以将语音和手势结合起来,给出一个适应性更强、更稳健的多模态无触摸界面。

对于语音或视觉控制的系统,机器必须快速可靠地区分故意的用户指令和随机或无意的输入。例如,只有当用户有意做出这种反应时,机器才应该打开,而不是仅仅因为一个人站在它附近说话。机器视觉系统可以识别手势,如手部动作、点头、挥脚和指点。解读肢体语言可以成为机器对人类操作者的可见输入做出反应的一种更自然的方式。

基于手势的解决方案开发

开发基于手势的解决方案的第一步是确定系统必须识别和解释哪些手势类型。例如,用户是只用手交流,还是全身运动?对于视觉系统来说,手指的运动会比整个身体更容易捕捉到吗?整个身体可能会被衣服或其他随身携带的物品部分遮住?

手势复杂度也是重要的设计参数。例如,开门可能只需要一个手势,但调整环境控制或改变生产线可能需要一系列复杂的手势。

最后,移动速度和环境条件也会起到重要作用,例如,当照明水平较低或太亮时。了解所有这些因素有助于确定所需摄像机传感器的数量和类型、视野、焦距以及检测和解释手势所需的分辨率。

此外,还建议提供一个备用接口,如语音控制或物理触摸屏,以防用户无法使用手势方法。对于工业环境中的安全关键功能,应用软件可能需要进行功能安全评估和认证,如针对工业系统的IEC61508。

把概念变成现实

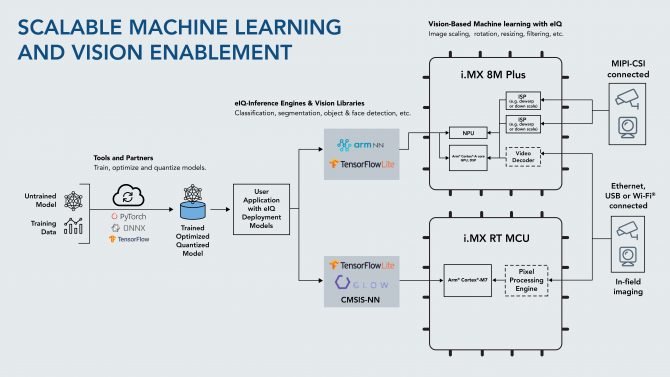

了解手势,环境和摄像头类型后,我们必须获取或建立手势识别机器学习模型。图1的左侧显示了将手势示例转换为推理引擎所需的步骤,该引擎实际上是识别手势的算法。TensorFlow,ONNX和Pytorch是用于此目的的一些常用工具。

只有现在我们才能确定合适的硬件和软件。手势识别系统通常建立在工业级嵌入式平台上,从连接到通用计算核心的单个智能摄像头,到为多核处理器提供高度优化视觉和机器学习加速器的多个摄像头传感器。图1显示了手势识别系统的两种选择,推荐用于更简单系统的i.MXRT微控制器平台,以及用于更复杂或更快响应手势和视觉系统的NXPi.MX8MPlus应用处理器。

立体视觉摄像头可以使用MIPI-CSI、USB或以太网连接以及音频输入,识别语音和声音发生器,以提供音频用户反馈。显示面板还可以向用户提供直观的指示和反馈,并且可以在非接触式控制发生故障或将不使用的情况下包含备用触摸屏。

最快的方法是利用现有的嵌入式平台和工具箱。例如,ToradexApalisi.MX8EmbeddedVisionStarterKit是一种工业级单板解决方案,基于NXPi.MX8应用程序处理器,结合AlliedVisionsensor,它利用AmazonWebServices(AWS)开发工具完成对象识别任务。该工具集可以收集手势示例,并将其传输到AWS工具中,以训练手势识别模型。然后,可以将生成的推理引擎加载回同一个工具包中,以识别手势并通知机器如何响应。

转自:http://www.qianjia.com/html/2020-09/29_371409.html

/5

/5