为实现AI大模型训练、科学计算等高算力需求工作,需要使用数百甚至上千个GPU 组成的计算单元作为算力基础评估、优化模型的配置和参数。为了使这样一个庞大 的计算单元能够有效发挥其效率,需要使用低延迟、高带宽的网络联接各个服务器 节点,以满足服务器/GPU间计算、读取存储数据的互联通信需求,同时对整个集群 系统进行管理。 服务器集群的网络系统包含服务器、网卡、交换机、线缆(包含光模块)等主要硬 件。就网络构成来看,网卡搭载于服务器内部,网卡直接与CPU相连或通过PCIe Switch与GPU相连;一层交换机通过服务器机身的端口与服务器内的 网卡相连;线缆用于实现服务器-交换机、交换机-交换机间的连接, 如果使用光信号实现信号传输,线缆两端均需要搭载光模块。

(一)服务器

我们参考NVIDIA DGX系列服务器的硬件配置,重点关注网卡、机身网络端口的配置 情况,分析服务器集群的网络架构发展在服务器硬件端的反映。

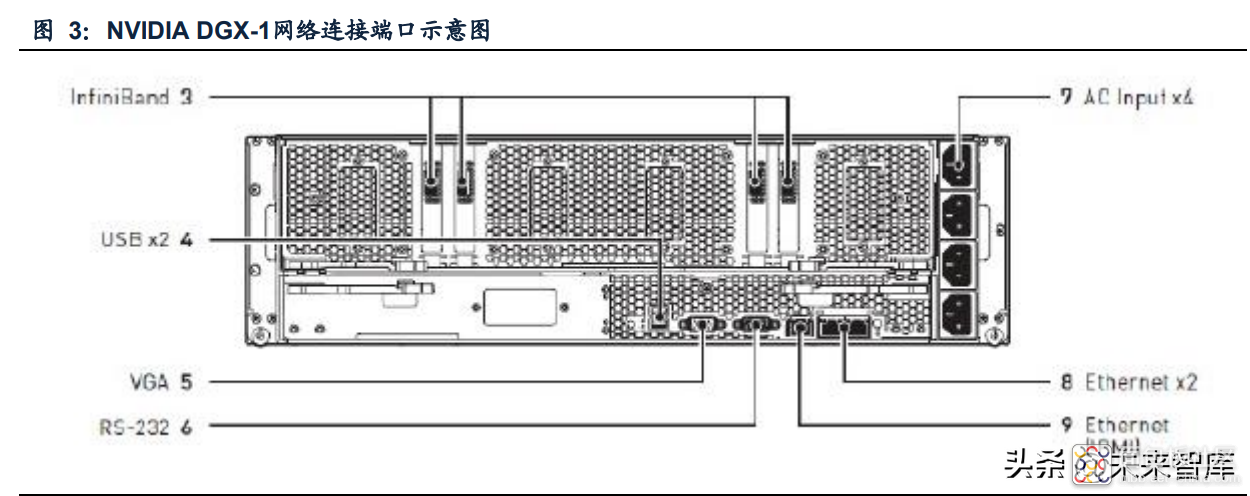

1. DGX-1

2016年,NVIDIA发布了搭载8颗V100的DGX-1服务器。服务器内配有4颗单端口 100Gb/s IB/以太网NIC。服务器机身有4个QSFP28端口,单端口支持100G EDR IB 网络或100G以太网络。此外,服务器机身还有2个10GBASE-T RJ45以太网端口、 以及1个10/100BASE-T IPMI网络RJ-45端口。

2. DGX-2

NVIDIA 2018年发布的DGX-2通过首代NVSwitch,内部搭载了16颗V100 GPU。服 务器内共有10个ConnectX-5网卡,其中8颗可用于连接100G IB或以太网络,其余2 颗用于100G以太网络。10张网卡对应服务器端的10个QSFP28端口。此外,服务器 端还有2个RJ-45端口,均支持千兆以太网,用于In-Band和Out-of-Band管理。

3. DGX A100

2020年发布的DGX A100搭载了新一代Mellanox ConnectX-6网卡,单端口支持的带 宽提高至200Gb/s。在DGX A100内,共有8个支持IB网络的单端口ConnectX-6网卡、 1个支持IB/以太网络的双端口ConnectX-6网卡,此外,服务器可选装1个双端口 ConnectX-6网卡。在服务器机身,共有12个QSFP端口,用于计算、存储、In-Band 管理;以及1个用于Out-of-Band管理的RJ-45端口。

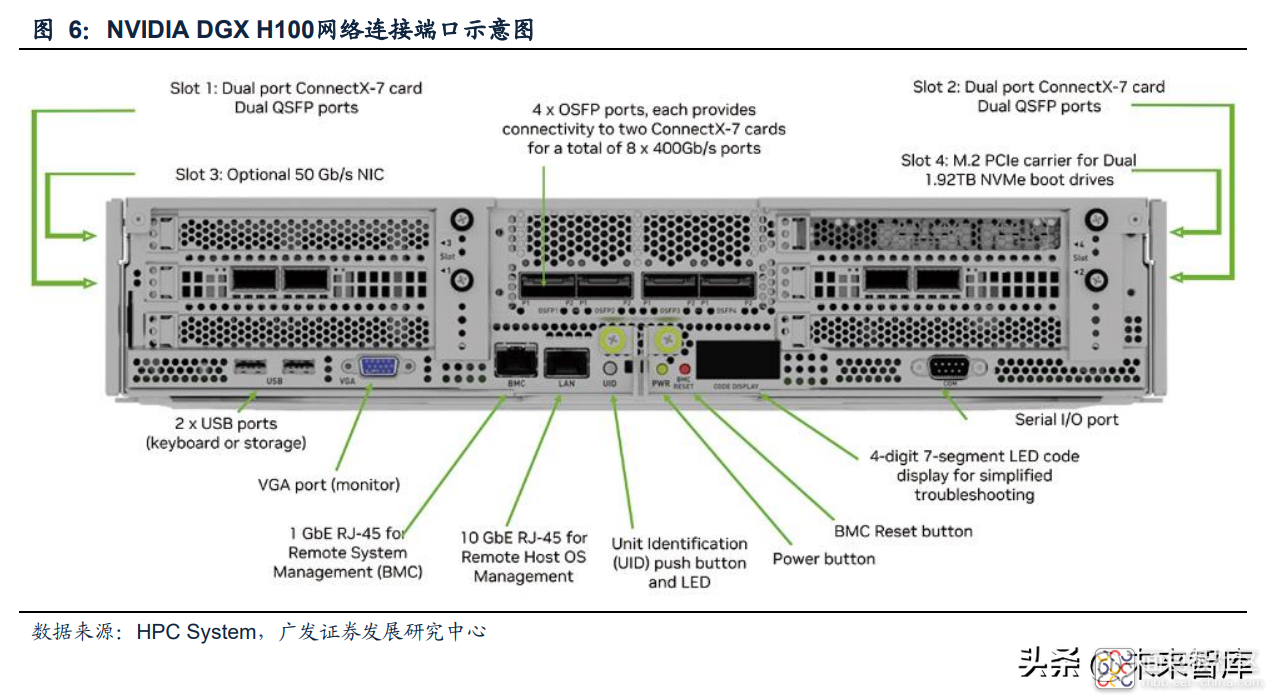

4. DGX H100

2022年最新发布的DGX H100搭载了8个可支持IB/以太网络的单端口ConnectX-7网 卡,最新一代ConnectX-7网卡支持NDR 400Gb/s带宽;此外还有2个可支持IB/以太 网络的双端口Bluefield-3 DPUs,单端口速率200Gb/s。服务器机身配有4个OSFP端 口用于计算网络连接;配有4个QSFP56端口,用于存储网络、In-Band管理网络;此 外还有1个用于Remote Host OS管理的10G以太网RJ-45端口、1个用于Remote System Management管理的1G以太网RJ-45端口。 在DGX H100服务器,网卡与端口的对应关系为:2个ConnectX-7网卡(400Gb/s) 对应一个OSFP端口(800G),1个Bluefield-3 DPU对应2个QSFP56端口。

(二)网卡

DGX A100和DGX H100服务器内分别搭载ConnextX-6和ConnectX-7网卡。 ConnectX-7相较于前者,在网络带宽、单网卡支持端口数量、PCIe适配性等方面均有提高。

(三)交换机

1. 计算网络、存储网络交换机

参考NVIDIA服务器集群设计,集群中计算网络、存储网络均使用IB网络互联,推荐 使用的服务器型号也是相同的。 DGX A100和DGX H100服务器集群内IB网络推荐使用的交换机分别为Mellanox QM8790和Mellanox QM9700。Mellanox QM9700相较于前者,在单端口网络带宽、 端口数量、总吞吐量方面均有提高。

2. In-Band管理网络、Out-of-Band管理网络交换机

DGX A100和DGX H100服务器集群内In-Band管理网络推荐使用的交换机分别为 SN4600和SN4600C;Out-of-Band管理网络推荐使用的交换机分别为AS4610和 SN2201。

(四)线缆、光模块

服务器-交换机、交换机-交换机间的连接主要通过DAC(Direct Attach Cable,一般 译为直接连接电缆或直连铜缆)或AOC(Active Optical Cable,有源光缆)。 DAC是两端带有固定接头的铜轴线缆组件,根据两端接头是否配有信号补偿等芯片, DAC可分为有源DAC和无源DAC;DAC中间传输的是电信号,不涉及到电到光或光 到电的转换;AOC由两端的光模块和中间的多模光纤组成,信息在AOC中以光信号 形式传输。

有源DAC、无源DAC、AOC都可以用于服务器-交换机、交换机-交换机之间的连接。 三种连接方式的主要区别在于传输距离、功耗和成本。

参考Mellanox/NVIDIA官网,200G DAC产品价格在300 ~1500美元不等,200G AOC 产品价格在2100 ~2300美元不等。

在接下来的二、三两章,我们参考NVIDIA DGX SuperPOD白皮书中关于服务器集 群网络的构建,针对DGX A100和DGX H100组成的集群,分析交换机、线缆、光 模块的数量需求。

二、DGX A100 服务器集群中单颗 A100 对应约 7 颗 200G 光模块需求

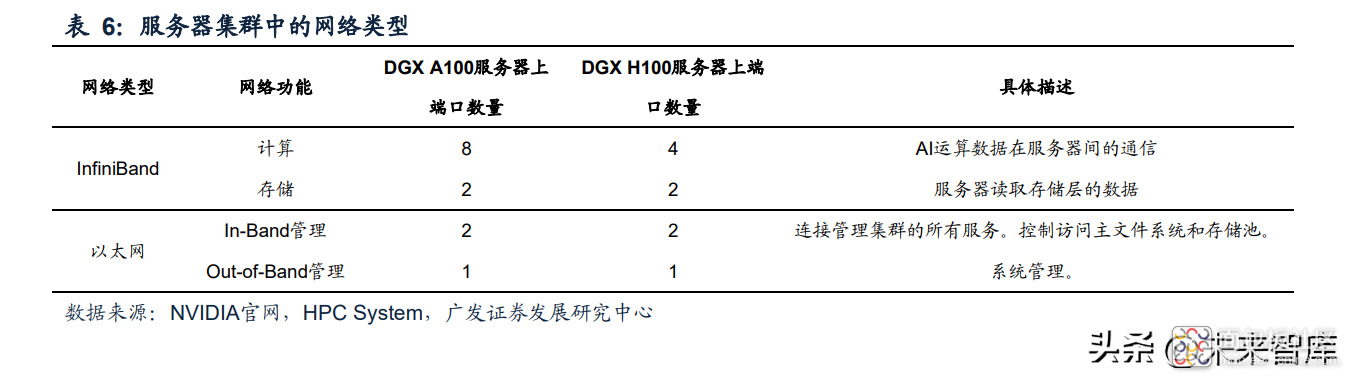

在DGX A100和DGX H100网络集群中,根据网络协议,主要使用InfiniBand和以太 网两类网络;根据服务器工作过程网络的功能,可以分为计算网络、存储网络、InBand管理网络、Out-of-Band管理网络四类。其中计算和存储使用IB网络,In-Band 管理和Out-of-Band管理使用以太网。

参考NVIDIA DGX A100集群的网络架构,在集群中每20台DGX A100组成一个SU, 每4台DGX A100被放置在一个单独的机架(Compute Rack)上,该机架上配有2个 配电单元(Power Distribution Unit,PDU);同时各类交换机被单独放置在一个机 架上;即每个SU包含6个机架(5个用于放置服务器、1个用于放置交换机)。

(一)计算网络(Compute Fabric)

在参数量较大的AI模型训练中,需要多个GPU协同并行工作;通过把数据在N个GPU 之间分配,即每个GPU并行处理1/N的数据量,理想情况下可以将训练速度提高N倍。 在实际工作过程中,各个GPU针对被分配的数据训练得到局部梯度(Local Gradients),在这个训练阶段结束后,GPU通过彼此通信来平均所有局部梯度,从 而得到全局梯度(Global Gradients),全局梯度会被反馈给每一个GPU,并进行后 续的训练过程。这个过程被称为全规约(通过平均来减少每个GPU的值,并反馈给 各个GPU),进行全规约运算过程中,GPU间的互联通信速度对于系统的算力表现 有非常直接且明显的影响。

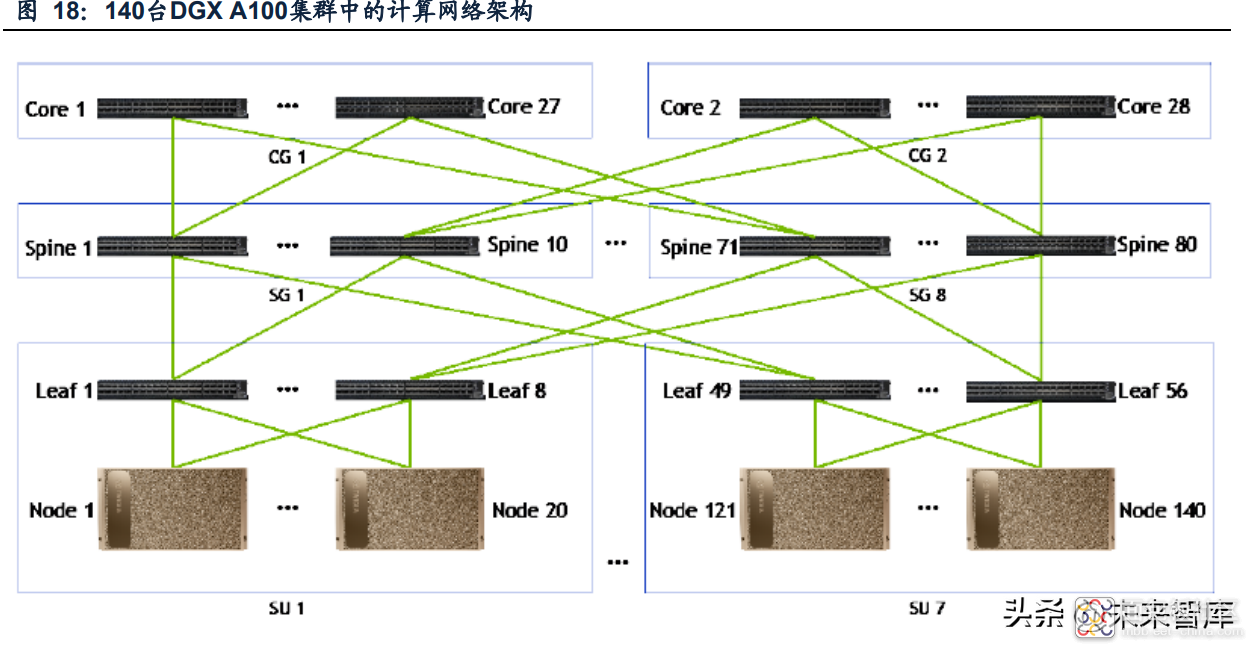

DGX A100集群中的计算网络可以应用到多达3层交换机,一到三层的交换机分别被 称为Leaf 交换机、Spine交换机、Core交换机(只应用在较大规模集群)。在DGX A100服务器集群中,三层交换机均使用40端口的Mellanox QM8790型号交换机。 计算网络架构的三层交换机: 集群中每20台DGX A100构成一个SU,每个SU中有8台Leaf交换机。每个SU中每一 台DGX A100与每一台Leaf交换机都有连接,这意味着SU中每一台DGX A100都连 接到同一台Leaf交换机,这种线路优化(rail-optimized)的网络架构对于提升深度学 习训练表现具有重要帮助。 十台QM8790交换机组成的第二层交换机组Spine Group(SG)用于优化网络架构, 实现不同SU之间的通信。在140节点集群系统中,共需要8组SG(对应80台交换机)。 14台QM8790交换机组成的第三层交换机组Core Group(CG)用于实现SG之间的 互联通信,在140节点交换机系统中,需要使用到两个CG,,即共需要28台交换机。

在80节点及以下的AI服务器集群中,计算网络架构仅包含两层交换机。

统计集群中计算网络交换机、线缆需求,在140台DGX A100组成的SuperPOD集群 中,共需要使用164台交换机、3364根线缆,对应连接6728个端口。

(二)存储网络(Storage Fabric)

服务器集群中的存储网络使用InfiniBand网络,存储网络需要提供较高的吞吐量以使 AI服务器获取共享存储(shared storage)的数据/信息。以140节点服务器集群为例, 存储网络架构包含两层交换机,共使用26台交换机、660根线缆,对应约1320个端 口。

(三)In-Band 管理网络、Out-of-Band 管理网络

服务器集群中的In-Band管理网络的主要功能包括:负责连接管理集群的所有服务; 管理控制集群中节点访问主文件系统和存储池以及集群内外其他服务的连接。服务 器集群中的Out-of-Band管理网络通过连接服务器内的BMC对系统进行管理,Outof-Band管理使用单独的低使用率网络系统,避免与其他集群内网络服务形成带宽的 竞争,对于保障集群的正常运行至关重要。 In-Band管理和Out-of-Band管理均使用以太网。在DGX A100集群中,In-Band管理 使用100Gb以太网,交换机型号为SN4600;而Out-of-Band管理使用1Gb以太网,交 换机型号为AS4610。

(四)DGX A100 服务器集群中光模块/光芯片数量需求测算

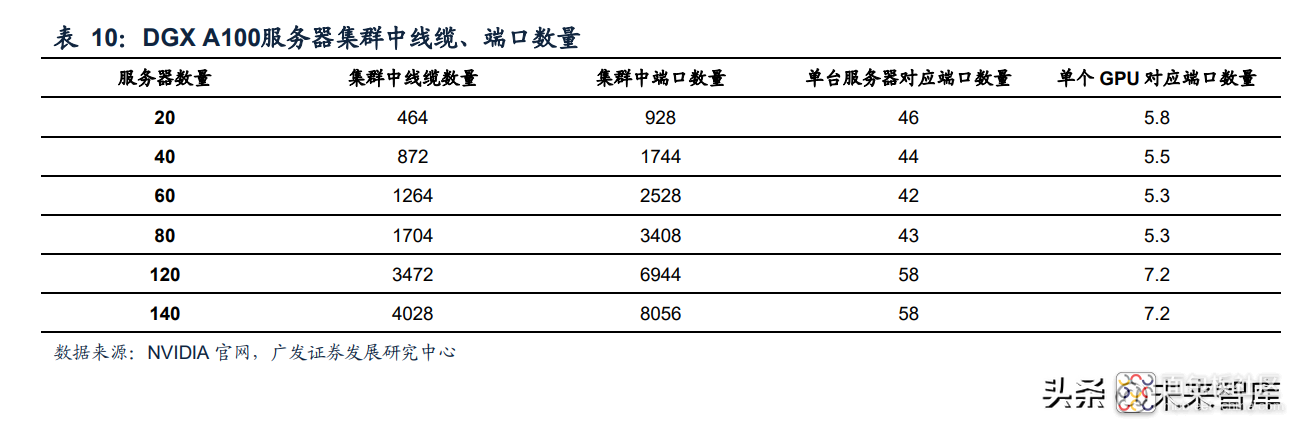

我们对DGX A100集群中光模块/光芯片的需求量进行测算,考虑到服务器集群中的 网络包括IB网络和以太网,其中IB网络的端口数量、单端口带宽均远高于以太网,因此我们通过测算计算网络和存储网络合计端口数量来测算集群网络中光模块/光芯 片的需求量。 测算得到服务器集群、集群中单台服务器、集群中单个GPU对应的端口数量如表10 所示。可以看出在20-80个DGX A100组成的集群中,单个GPU对应的端口数量为 5.3~5.8个;在120、140个DGX A100组成的集群中,单个GPU对应的端口数量为7.2 个;两者差异主要由于120及以上节点的集群中,计算网络增加了第三层交换机(CG), 相应增加了交换机、线缆、端口数量需求。

考虑DGX A100服务器集群中,服务器端、交换机端IB网络端口均使用QSFP56,因 此系统中50G光芯片(收、发芯片记为一颗)与200G光模块数量比为4:1。基于此前 提,我们测算得DGX A100集群中单个GPU对应约28颗50G光芯片需求。

三、DGX H100 服务器集群中单颗 H100 对应约 1.5 颗 800G 光模块+2 颗 400G 光模块需求

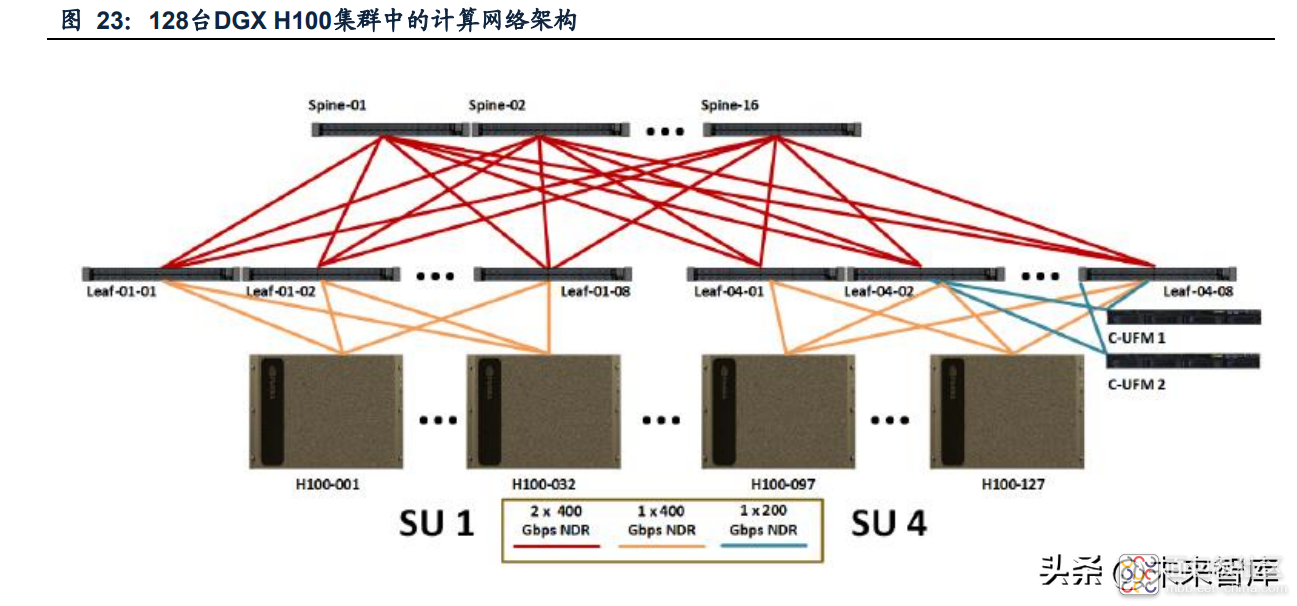

在NVIDIA DGX H100服务器集群中每32台DGX H100组成一个SU,每4台DGX H100被放置在一个单独的机架上,每个机架上配有3个配电单元(PDU);同时各 类交换机被放置在两个独立机架上;即每个SU包含10个机架(8个用于放置服务器、 2个用于放置交换机)。

(一)计算网络(Compute Fabric)

根据NVIDIA参考设计,在128台DGX H100服务器组成的集群中,计算网络只需要使 用到两层交换机,两层交换机均使用Mellanox QM9700型号交换机。 集群中每32台DGX H100构成一个SU,每个SU中有8台Leaf交换机。在SU中每个 DGX H100都需要与8台Leaf交换机有连接,由于每个服务器只有4个用于计算网络 连接的800G OSFP端口,在每个端口接800G光模块后,通过拓展端口将1个OSFP 端口拓展为2个QSFP端口,实现每台DGX H100与8个Leaf交换机的连接。在服务器 端需使用800G光模块,服务器端的800G光模块需求量为4*32*4(第一个4:每个服 务器有4个800G OSFP端口;32:每个SU中有32台服务器;第二个4:集群中有4个 SU)

在Leaf交换机的下行端口需使用400G光模块,需求量为32*8*4(32:每个Leaf交换 机有32个下行端口用于连接32台服务器;8:每个SU中有8台Leaf交换机;4:集群 中有4个SU) Leaf交换机的上行端口使用800G光模块,需求量为16*8*4(16:每个Leaf交换机有 16个上行端口用于连接16台Spine交换机;8:每个SU中有8台Leaf交换机;4:集群中有4个SU) Spine交换机的下行端口使用800G光模块,需求量为32*16(32:每个Spine交换机 有32个下行端口用于连接32台Leaf交换机;16:集群中有16台Spine交换机)。 基于以上测算,在该服务器集群中,计算网络应用到的800G光模块数量为1536,应 用到的400G光模块数量为1024。每台DGX H100对应12个800G光模块、7.3个400G 光模块;即每颗H100对应1.5个800G光模块、0.9个400G光模块。

(二)存储网络(Storage Fabric)

在DGX H100服务器集群中,存储网络的连接主要通过400G/200G光模块/光纤。由 于网络中Leaf交换机与存储设备的连接所需的光模块/线缆数量有一定变化性。因此 我们基于以下假设对存储网络中端口/光模块的需求数量进行测算:根据NVIDIA白皮 书信息,在128台DGX H100服务器组成的集群中,存储网络共需要使用16台 QM9700交换机,我们假设每台DGX H100端的2个存储网络端口、每台交换机端的 64个400G端口均配有光模块,即不考虑部分冗余端口未配有交换机、同时未考虑 UFM和存储设备端的光模块需求。基于以上假设我们测算得系统中共需要 128*2+16*64,即1280颗400G光模块,即每台服务器对应10颗400G光模块,每颗 GPU对应约1.25颗400G光模块。

(三)DGX H100 服务器集群中光模块/光芯片数量需求测算

同DGX A100集群的测算过程,我们只考虑DGX H100服务器集群中计算网络和存储 网络对光模块的需求。 测算得在DGX H100集群中,每颗H100对应1.5个800G光模块和2.15颗400G光模块 需求,每颗H100对应约20颗100G光芯片需求。

(本文仅供参考,不代表我们的任何投资建议。如需使用相关信息,请参阅报告原文。)

精选报告来源:【未来智库】。

/5

/5