aeabe7982c11a2d78a32ad0c17374978cec3cab7.jpg1200x750 116 KB

aeabe7982c11a2d78a32ad0c17374978cec3cab7.jpg1200x750 116 KB 近日,麻省理工学院发布了一款名为“道德机器(Moral Machine)”的调查平台,采集用户对于无人驾驶汽车的道德倾向,以作为研究未来无人车道德决策的数据样本。

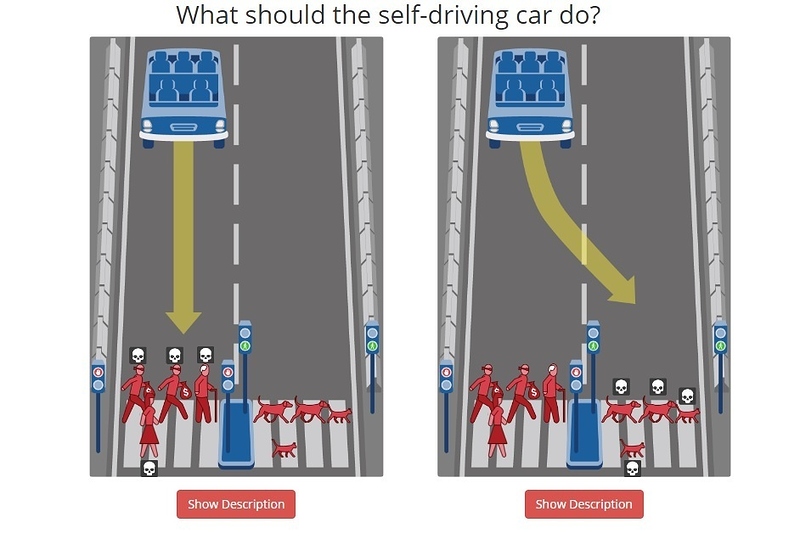

被调查者要经受一系列考验,以确定各个道德维度上的倾向。比如,刹车失灵时,是撞死闯红灯的行人,还是绿灯通过的猫和狗。

5669b951336d41e494a1b578a8a52f268999ef40.jpg942x642 96.3 KB

5669b951336d41e494a1b578a8a52f268999ef40.jpg942x642 96.3 KB 还有附带性别倾向的题目:是保护过马路的女性,还是保护车上的男性?

b0bee1fd385fd1bee4b27fa90a4a09142ae7982a.jpg864x656 85.4 KB

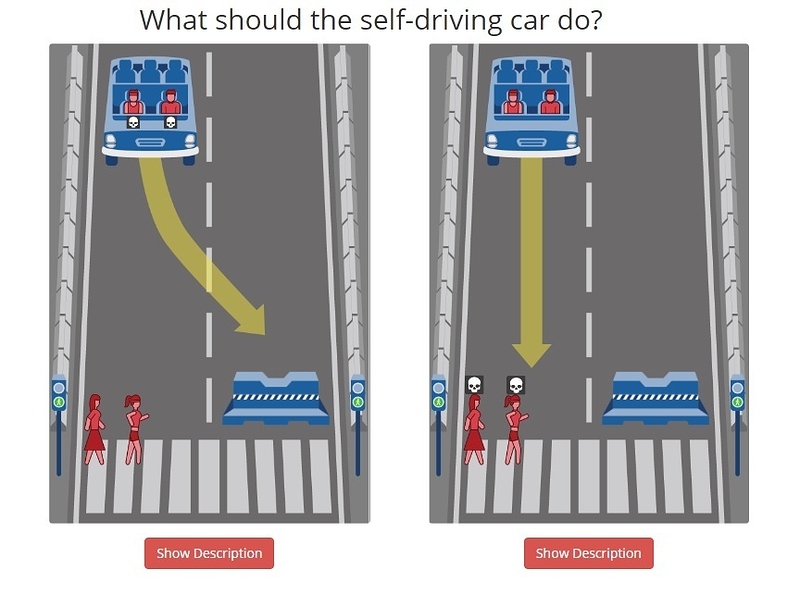

b0bee1fd385fd1bee4b27fa90a4a09142ae7982a.jpg864x656 85.4 KB 还有这种极个别情况:是保护车上的猫还是撞死罪犯?

bd2624b9437ac3056a9caccde36882475f477238.jpg848x664 84.9 KB

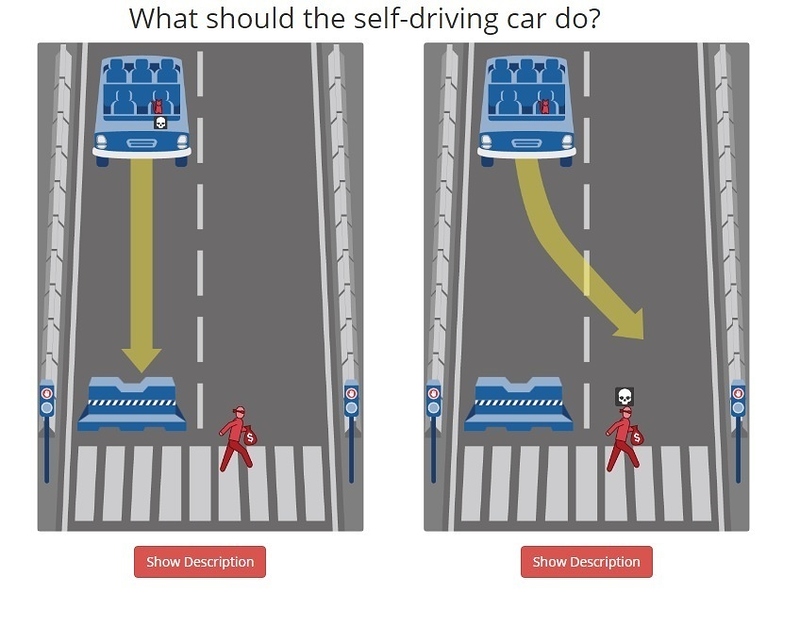

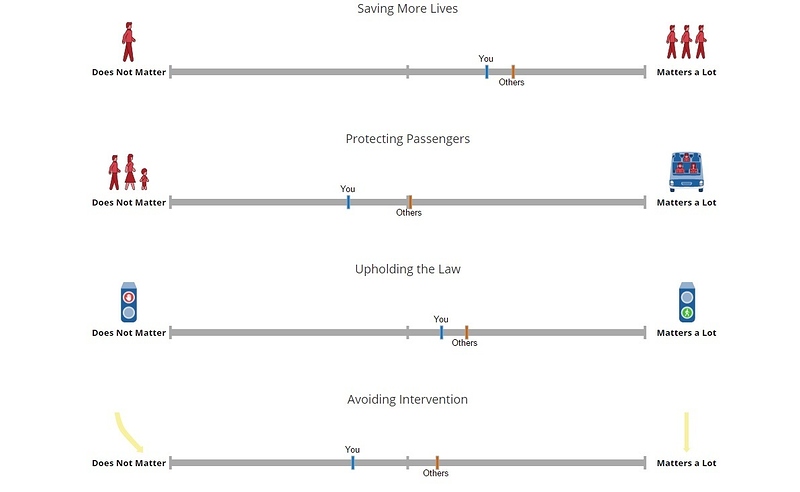

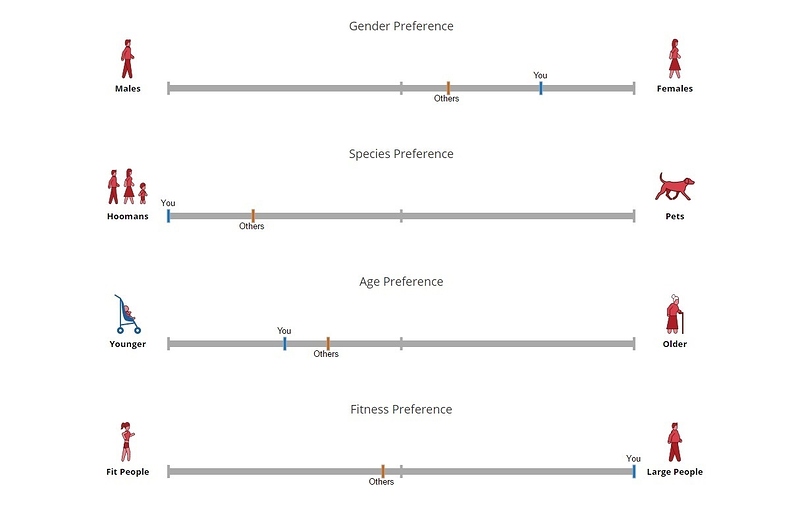

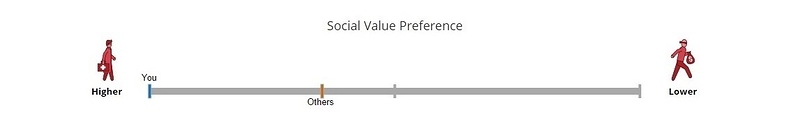

bd2624b9437ac3056a9caccde36882475f477238.jpg848x664 84.9 KB 某媒体也参加了测试,得出的道德倾向从9个维度上进行解释,比如,年龄倾向、物种倾向、是否遵纪守法、保护乘客还是行人等等。

353278386e103a4607198bfff0137d8817ceb4b4.jpg1192x734 50.6 KB

353278386e103a4607198bfff0137d8817ceb4b4.jpg1192x734 50.6 KB  3f5306e4cf0bc709bebcb7c5549f91a71bf4b041.jpg1215x776 46.1 KB

3f5306e4cf0bc709bebcb7c5549f91a71bf4b041.jpg1215x776 46.1 KB  7a9dc197d50a4044f6842b4e5d0e0ace562556cc.jpg1154x199 12 KB

7a9dc197d50a4044f6842b4e5d0e0ace562556cc.jpg1154x199 12 KB 此外,受访者还可以自己创造其他情形,并浏览其他人的创造的道德抉择。MIT 希望通过这种方式尽可能多的覆盖可能的情况。

MIT 表示,当今的人工智能在为人类提供越来越多的支持,在某些领域甚至有代替人类的倾向。在可见的未来,驾驶就是一项可以被机器替代的工作。

机器在未来不可避免地要自行做出平常人类才会面对的道德抉择,有些情况下,还会牵扯到人的生命。

在紧要关头该保护谁,该抛弃谁,这是这个社会不愿面对,但是必须要解决的问题。

我们也看到,在测试过程中,歧视、法律观念等等平常我们避而不谈的价值观争议被暴露无遗。而想要进一步推进无人驾驶,社会上的每个人都需要正视这些丑陋的现实,并为未来无人驾驶的道德决断提供一个普世的准则。

MIT面对这个难题,选择了一条可能是最公正的路径——让成千上万的公众自己决定。

MIT面对难题,交给公众自己决定。如果交给您做这项决定,您会怎么选择?

文/胡润泽

来源:爱范儿

/4

/4