AI算力芯片主要包括GPU、FPGA,以及以VPU、TPU为代表的ASIC芯片。其中以GPU用量最大,据IDC数据,预计到2025年GPU仍将占据AI芯片8成市场份额。然而,相较传统图形GPU,通用型算力GPU在芯片架构上缩减了图形图像显示、渲染等功能实现,具有更优的计算能效比,因而被广泛应用于人工智能模型训练、推理领域。

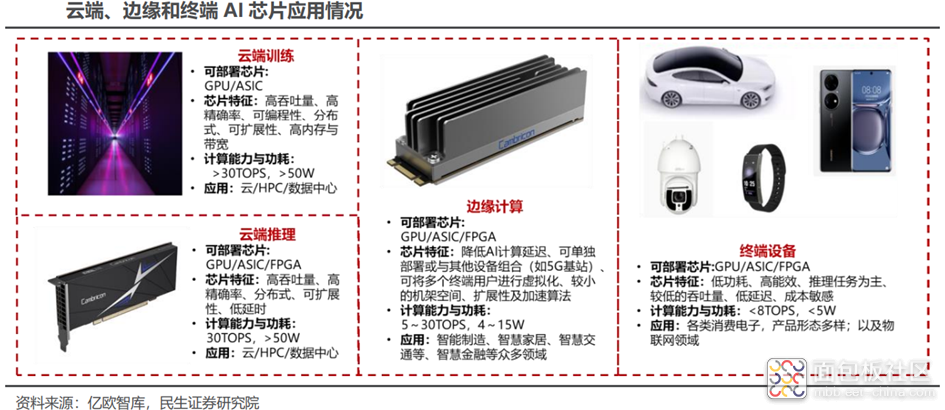

根据在网络中的位置,AI芯片可以分为云端AI芯片、边缘和终端AI芯片;根据其在实践中的目标,可分为训练(training)芯片和推理(inference)芯片。云端主要部署高算力的AI训练芯片和推理芯片,承担训练和推理任务,具体有智能数据分析、模型训练任务和部分对传输带宽要求比高的推理任务;边缘和终端主要部署推理芯片,承担推理任务,需要独立完成数据收集、环境感知、人机交互及部分推理决策控制任务。

由于英伟达GPU产品线丰富、产品性能顶尖、开发生态成熟,目前全球AI算力芯片市场仍由英伟达垄断。根据中国信通院的数据,2021年Q4英伟达占据了全球95.7%的GPU算力芯片市场份额,因此,英伟达数据中心业务营收增速可以较好地反应全球AI芯片市场增速。2023财年,英伟达数据中心营收达到150亿美元,同比增长41%,FY2017-FY2023复合增速达63%,表明全球AI芯片市场规模保持高速增长。

性能与生态构筑AI算力芯片高壁垒

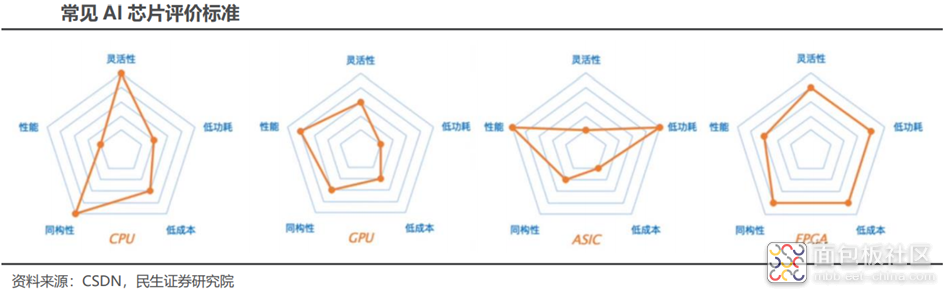

评价AI芯片的指标主要包括算力、功耗、面积、精度、可扩展性等,其中算力、功耗、面积(PPA)是评价AI芯片性能的核心指标:

算力:衡量AI芯片算力大小的常用单位为TOPS或者TFLOS,两者分别代表芯片每秒能进行多少万亿次定点运算和浮点运算,运算数据的类型通常有整型8比特(INT8)、单精度32比特(FP32)等。AI芯片的算力越高,代表它的运算速度越快、性能越强。

功耗:功耗即芯片运行所需的功率,除了功耗本身,性能功耗比是综合衡量芯片算力和功耗的关键指标,它代表每瓦功耗对应输出算力的大小。

面积:芯片的面积是成本的决定性因素之一,通常来讲相同工艺制程之下,芯片面积越小良率越高,芯片成本越低。此外,单位芯片面积能提供的算力大小,亦是衡量AI芯片成本的关键指标之一。

除PPA之外,运行在AI芯片上的算法输出精度、AI应用部署的可扩展性与灵活性,均为衡量AI芯片性能的指标。

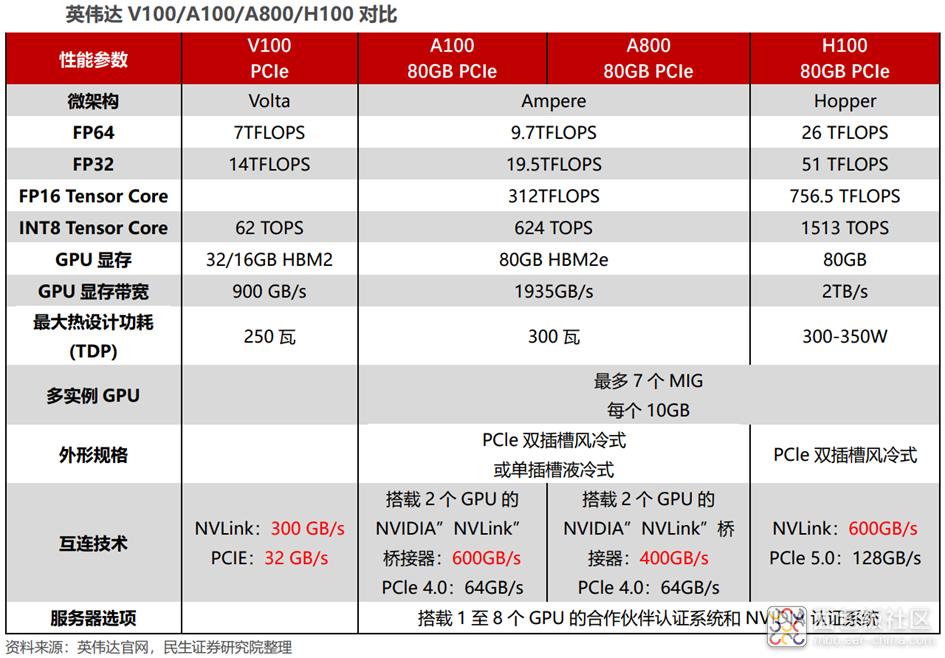

英伟达的GPGPU是全球应用最为广泛的AI芯片,决定其性能的硬件参数主要包括:微架构、制程、CUDA核数、Tensor核数、频率、显存容量、显存带宽等。其中,微架构即GPU的硬件电路设计构造的方式,不同的微架构决定了GPU的不同性能,作为英伟达GPU的典型代表,V100、A100、H100 GPU分别采用Volta、Ampere、Hopper架构;CUDA核是GPU内部主要的计算单元;Tensor核是进行张量核加速、卷积和递归神经网络加速的计算单元;显存容量和带宽是决定GPU与存储器数据交互速度的重要指标。

除GPU硬件之外,与之配套的软件开发体系亦是生态的重要组成部分。GPU的生态包括底层硬件、指令集架构、编译器、API、基础库、顶层算法框架和模型等,英伟达于2006年发布的CUDA平台是当今全球应用最为广泛的AI开发生态系统。通用GPU与CUDA组成的软硬件底座构成了英伟达引领AI计算的根基,当前全球主流深度学习框架均使用CUDA平台。

生态构建计算壁垒,国产GPU厂商初期兼容CUDA,长期仍需构筑自身软硬件生态。由于当前全球主流深度学习框架均使用CUDA平台进行开发,国产GPU可以通过兼容CUDA的部分功能,快速打开市场,减少开发难度和用户移植成本。然而,CUDA本身涵盖功能非常广泛,且许多功能与英伟达GPU硬件深度耦合,包含了许多英伟达GPU的专有特性,这些特性并不能在国产AI芯片上全部体现。因此,长期来看国产GPU厂商仍需通过提升自身的软硬件实力,构筑属于自己的软硬件生态。

/4

/4