HBM 全称 high bandwidth memory,新型 CPU / GPU 内存芯片,是一种基于 3D 堆叠工艺的 DRAM 内存芯片,被安装在 GPU、网络交换设备、AI 加速器及高效能服务器上。

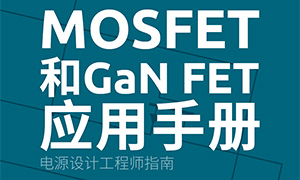

HBM的立体结构:

资料来源:AMD

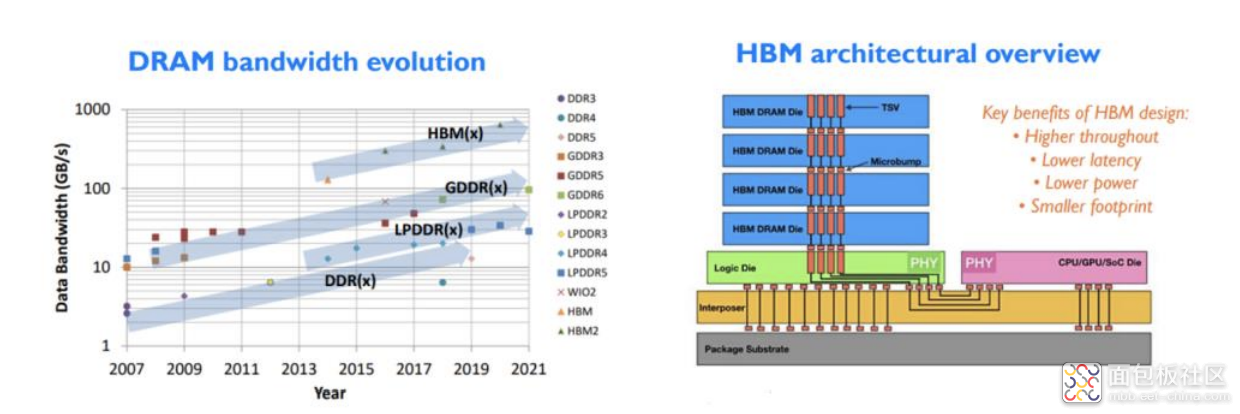

以 HBM 为代表的超高带宽内存技术生成类模型也会加速 HBM 内存进一步增大容量和增大带宽。

HBM 能大幅提高数据处理速度,每瓦带宽比 GDDR5 高出 3 倍还多,且 HBM 比 GDDR5 节省了 94%的表面积。

DRAM 带宽迭代历程及 HBM 架构概览:

资料来源:YOLE

HBM 将多个 DDR 芯片堆叠后和 GPU 封装在一起, 实现大容量、高位宽的 DDR 组合阵列。通过增加带宽,扩展内存容量,让更大 的模型,更多的参数留在离核心计算更近的地方,从而减少内存和存储解决方案带来的延迟。

根据 Yole 预测,DRAM 所用的 TSV 封装技术(HBM/3Ds)及混合键合技术将在存储封装市场中取得亮眼进展,二者合计占 比将由 2020 年的 5%上升至 2026 年的 17%,实现 32 亿美元的市场规模。

此外,高速运算催生的新协定,CXL 将更有效整合系统中的运算资源。未来 AI 服务器的硬件建设,将能见到更多同时采用 HBM 及 CXL 的设计。其中 HBM 能分别增加 CPU 及加速器各自的频宽,加速数据处理速度; CXL 则建立彼此间沟通的高速互联性,两者交互有助于扩展 AI 算力从而加速 AI 发展。

随着AI 服务器出货动能强劲,以及AI 芯片性能及成本的平衡会带动周边生态,HBM产业链有望全面受益。

/4

/4