据中国科学报介绍,“他们用计算机视觉和机器学习技术,检测了1856张中国成年男子面部照片,其中将近一半是已经定罪的罪犯。实验结果显示,罪犯与非罪犯这两个群体可由基于机器学习的人脸分类器以较高的概率加以区分。此外,罪犯与非罪犯在内眼角间距、上唇曲率和鼻唇角角度这三个测度上存在较显著差异。更重要的发现在于,犯罪分子之间的面孔特征差异要大于守法公民。”

论文发表后,很快在国内外引起了广泛的争议。

时隔半年后,近日,谷歌的几名研究员更是撰文两万字批驳上交大用深度学习推断犯罪分子 。谷歌研究院的文章有一次将交大的研究推向舆论热议。

论文发表地址:

Automated Inference on Criminality using Face Images

https://arxiv.org/pdf/1611.04135v1.pdf

争议:歧视和误导

一名留学在外的上海交大校友:“我建议你(指武筱林)撤销这篇论文,并且上传一封公告,为不恰当的研究方法致歉。”理由是“这篇论文充满了极度的歧视和强烈的误导。我们人工智能领域的研究者不应当滥用技术,去做一些违反伦理的事情”。“这篇论文给上海交大的声誉带来了很糟糕的影响。这对那些申请美国高校的上海交大学子来说,将会是一场灾难。”

美国康奈尔大学的科研同行:“我是来敦促你撤稿的,因为这是一项可耻的工作。我们无法选择自己的唇部弧度、眼间距和所谓的鼻唇角角度。但犯罪者的问题在于行为,而不是长相。”他还指出,作者可能忽略了一个问题:有些人可能恰恰因为长相与众不同而更容易被判定有罪。“这种既有歧视应当被谴责和消除,而非被扩大!”

加拿大麦克马斯特大学电子与计算机工程系主任蒂姆·戴维森教授则指出,这项研究应当促使人们反思一个问题:长相偏离均值的人是否更容易遭受所谓“主流”人士的歧视和排斥,而其中一些人会因此走上违法道路?

研究者称:这本来是一个纯粹的科学问题!

武筱林非常愤怒:“有些人站在道德高地谴责我制造歧视,部分言论明显带着对中国学者的偏见。我很生气,这本来是一个纯粹的科学问题!”上海交大的两位研究人员,他们无意争论此种社会刻板印象,而是想了解利用机器学习方法根据静态脸部照片判断一个人是犯罪分子或不是犯罪分子的准确率有多高。

他们的研究初衷是反对“相由心生”。武筱林解释称,自古以来,各个文化中都有类似“相由心生”的说法。就连亚里士多德都认为,由外部特征可以推断人的秉性。“最开始,我们是抱着怀疑的态度,想用现代科学方法去证伪这种观点。“得出现在这个结论,我们自己也很意外。”武筱林说,他们也曾从各个角度质疑自己的研究。

既然说是科学问题,自然有较真的科学家来“怼”了

近日,谷歌的几名研究员撰文对交大的这一研究进行了技术性质疑。

以下是这篇文章的节选:

新智元编译

1. 首先,谷歌研究员对交大论文给出的精度表示怀疑。

要看准确率高达 90% 是个什么概念,我们来对比另外一篇论文。计算机视觉研究人员 Gil Levi 和 Tal Hassner 在一篇精心控制的 2015 年论文中发现,具有相同架构的卷积神经网络(AlexNet)在推测快照中人脸性别 时的准确率只有 86.8%。另外,吴和张在论文中声称基于 CNN 方法的“假阳性”(即将“非罪犯”误识别为“罪犯”的错误率)只超过 6% 一点点。新的研究显示,药物检测一般会在 5% 至 10% 的病例中产生假阳性结果,10% 至 15% 的病例中为假阴性。2. 谷歌研究员认为交大研究的样本有不确定性。

我们认为论文中声称的准确度高得有些不切实际。一个技术问题是,少于 2000 个样本实际上是不足以训练和测试像 AlexNet 这样的 CNN (卷积神经网络)而不会过拟合(overfitting)的。论文采用较旧的非深度学习方法给出的较低的准确率(其实还是很高了)可能更为真实。

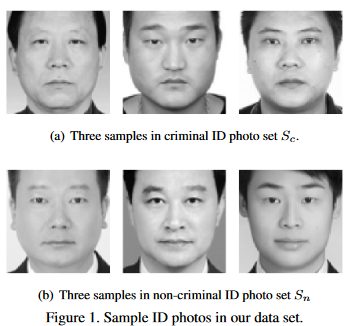

吴和张的数据集是身份证照片,一组含有 1,856 张 80x80 像素的中国男性面孔近照。这些男性年龄介于 18 至 55 岁之间。图像中的 730 个人被标记为“罪犯”,其他 1126 张人脸图像则是“使用网络爬虫从互联网获取的非犯罪分子头像。”吴和张用这些带标签的样本做监督学习,训练计算机看一张脸像,并产生一个“是/否”的回答。3.机器学习究竟学到了什么?

还应该注意,作者无法可靠地推断出他们从网络获取的身份证图像都是“非犯罪分子”的;如果我们假设这些人是一般人群中抽取的随机样本,根据统计学,其中一部分人也可能从事犯罪活动。

另一方面,论文中使用的数据集都是来自 18 只 55 岁的男性,这可能也有问题,因为法官在判决时可能会首先考虑排除年龄偏见。

同样,论文中所示的 3 个“非罪犯”图像(见上文图片)中都穿着白领衬衫,而另外 3 名被判别为“罪犯”的都没有。当然,只有 3 个例子,我们不知道这是否代表整个数据集。但是,我们知道,深度学习技术是强大的,并且能够学会所有接收到的线索,正如 ChronoNet 除了图像内容的不同之外,还提取了细节,如胶片颗粒度。

机器学习不会区分因果关系和偶然的相关性。

排除可能会影响论文所声称准确度的技术错误和混淆,图像中捕获的人脸外观与“罪犯”组中的成员之间可能确实存在相关性。这些被称为“罪犯”的人脸部有什么独特的特征吗?4.论文中声称输入和输出的客观性是具有误导性的。

吴和张使用了各种技巧对此作了详细的探讨。对于较为简单的机器学习方法,其中会测量标准面部标记(landmark)之间的关系,这是特别容易的。他们总结说,

“……犯罪分子从两边嘴角到鼻尖的角度 θ 平均值比非犯罪者的平均值要小19.6%,差异较大(has a larger variance)。而且,犯罪分子的上唇曲率 ρ 平均比非罪犯大 23.4%。另一方面,犯罪分子内眼角之间的距离 d 比非犯罪分子略窄(5.6%)。”

关于这一点,我们可以从论文中的配图得到直观的了解。下图是论文中的图1,上面一排是“罪犯”,下面一排则是“非犯罪分子”。

上排是“罪犯”,下排是“非犯罪分子”。上排的人脸表情皱着眉头(frowning),而下排没有。深度学习系统可能会“学会”这样表面的区别。

论文作者只公开了上面这 6 个例子,这也有可能是故意挑选的。我们也做了随机调查(包括中国和西方国家的同事),如果必须在二者中选择一组,很多人也认为下面一排的 3 个人是罪犯的可能性小一些。一方面,尽管作者声称对面部表情做了控制,但是底部 3 张图像似乎都是显得在微笑的,而上排的 3 个人则似乎是皱着眉头。

如果这 6 幅图像确实是典型的样本,那么我们怀疑让一名人类法官将图像从微笑到皱眉来排个序,也可以很好地将“非罪犯”与“犯罪分子”区别开来。

在看一张面部照片时,一台机器作为“犯罪检测器”看到的东西,和人类在看到这张肖像时看到的东西并无不同。

这项工作最令人不安的是,它引用了两种不同形式的权威力量——科学和法律。结论

从根本上说,“‘犯罪类型’在人脸上显而易见的认识,可能取决于几个有缺陷的假设:一个人的脸部外观纯粹是天生的;“犯罪”是某一群人的天然属性;法律制度下刑事判决定罪不受面部外观影响。

1)面部结构不是纯天生的,而是受成长、环境的强大影响。人脸的照片同时取决于摄影过程中的设定。所有这些附加因素都会在人脸的感知中发挥重要作用——这些都不容忽视。面部外观受到本质(遗传学)和非本质(环境、情境)因素的影响。

2)罪犯真的是一种“类型”吗?谷歌文章中说:“罪犯阶级”的思想在社会阶层的观念上是非常有限的。在实践中,绝大多数被运送的罪犯都是穷人,他们的许多罪行——就像任何一个时代——都是贫穷所致。他们的“犯罪”原来是环境所致的,而非本质的。

深度学习可以更好地从图像中提取细微的信息差别,而不是简单的特征测量,如面宽比。

3)判决。谷歌文章中指出:在美国,作为一名黑人男性,你被监禁的可能性是白人男性的七倍。事实上,有证据表明,在很多情况下,如果忽视面部特征,依靠关于世界的常识,我们将会做得更好。

机器学习也可能被误用,而这往往是无意的。这种误用往往是源于对技术问题狭隘的偏执,包括:交大教授回应看脸识罪犯质疑

- 缺乏对训练数据偏见来源的洞察力;

- 缺乏对该领域现有研究的仔细审查,特别是在机器学习领域之外;

- 不考虑可以产生测量相关性的各种因果关系;

- 不考虑机器学习系统应如何被实际使用,以及在实践中可能有什么社会影响。

5月9日,武筱林向澎湃新闻回应道:“那三个美国作者忽略我们原文中的一再声明,我们没有兴趣也无社会科学的学术背景解释我们的结果,讨论其成因。更没有暗示要用于执法司法。他们硬把这些意思强加给我们。”

“在价值观上我们与此文作者没有任何差别,他们歪曲我们的初衷,为了自己找一个假想敌。”武筱林强调。

大众的评论

(中国科学报,新智元,澎湃新闻,新浪微博)

/2

/2