并不是每一个HPC在分析工作负载时都能很好地适应256GB甚至512 GB的内存空间,在数据集非常庞大的时候,用较大的内存空间运行会更好,而不是把它分割成小块,用相同数量的原始计算分散到各个节点上。

Lawrence Livermore国家实验室,拥有非常强大的超级计算机,他们也是HPC前500强的常客,他们正在建造一个叫做“猛犸”的内存密集型的计算机,这是由AMD、LLNL研究人员、Supermicro和Cornelis Networks合作设计的。特别值得注意的是,虽然这个集群已经有足够的运算处理能力,但它的重点是提供 "大内存 "计算能力。换句话说,它安装的内存比人们对典型的HPC集群的认知要大得多。

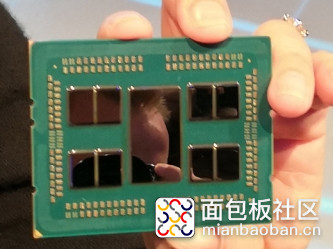

Lawrence Livermore宣布了这一庞大的系统已经运行了一段时间,它是基于高端64核版本的,搭载两颗AMD第二代“Rome”Epyc 7002处理器让它的表现更强劲,其中央处理器设计实现了一个中央输入输出集线器,所有芯片外的通信都通过该集线器进行。完整的设计使用了八个核心小芯片,称为核心复合芯片(CCDs),一个用于输入/输出的中心芯片,称为输入/输出芯片(IOD)。所有的CCD通过专用的高速无限光纤(IF)链路与这个中央I/O中心进行通信,通过这个核心可以与内部的DRAM和PCIe通道或其他核心进行通信,内存占用比英特尔的Xeon SP处理器更大,后者每插座最多只能有6个控制器。

根据Lawrence Livermore提供的信息,每个Mammoth节点都有一对AMD Epyc 7742处理器。这是这些芯片在2019年8月上市时,这也是英伟达为其DGX A100混合CPU-GPU系统选择的处理器。今年2月,AMD提升了Rome芯片的时钟速度,推出了64核版本Epyc 7H12,时钟频率为2.6 GHz,但功耗280瓦。Lawrence Livermore和Nvidia的Epyc 7742都选择了较慢的2.25 GHz,但功耗只有225瓦,成本仅为6950美元。节省下来的钱可以用来提高系统的主存容量。

更准确地说, 在重点的内存配置方面,Mammoth集群的每台服务器都装了2TB的DRAM和4TB的非易失性内存,因此可用的总内存是128TB的DRAM,以及256TB的NVRAM。这就是强调的"大内存"。相比之下,在一对2.6 GHz的18核“Cascade Lake”Xeon SP处理器上使用24个2.93 GHz的DDR4,Xeon SP处理器在STREAM Triad基准测试中提供大约140 GB/sec的记忆体带宽,但是当2.93 GHz的DDR4记忆体用于更高性能的部分时,这对英特尔芯片的记忆体带宽峰值为282 GB/sec。显然,AMD有很大的内存带宽优势。

就本地存储容量而言,每个Mammoth节点有3.84 TB的闪存,外加一个运行速度100 Gb/秒的全路径网络接口卡,该网络接口卡来自Cornelis Networks,后者最近从英特尔手中接管了全路径InfiniBand网络业务。每个节点都有4.6TOPS的峰值双精度性能。

Mammoth集群拥有一个全路径网络,运行速度为100 Gb/秒,采用FatTree胖树拓扑结构。这是对网络中机架顶部和聚合交换机之间有多少链路的度量,一般来说,只要分布式计算系统中的节点之间传输消息越少,那么链路越少,物理交换机越少,网络成本越低,对性能的影响就不会那么大。但是对于消息量大的话,锥形网络的有效带宽将低于完全供应的FatTree网络。

Mammoth拥有8192个内核,提供294 TOPS的峰值双精度性能,这是通过128TB的主存和245TB闪存来平衡的。据我们所知,内存共享是由消息传递接口(MPI)完成,并且没有像TidalScale或ScaleMP这样的附加层将内存组合成更大的聚合或单个共享内存空间。

据了解,Mammoth的高性能也在地域疫情期间出了不少力。

研究人员认为,Mammoth的特殊配置将提供它们所需的计算效率,这对数据密集型的COVID-19研究和大流行病响应等项目可以更好地去优化。它将同时用于 "基因组学分析、非传统的HPC模拟和图形分析,这些都是从事COVID-19研究的科学家们所需要的,包括抗病毒药物和设计抗体的开发。

研究人员已经通过Mammoth尝试分析SARS-CoV-2病毒的基因组,探究该病毒如何进化,并研究突变的可能性。参与该项目的科学家表示,这套系统可以将基因组分析所需的时间从几天减少到几个小时。这个新集群其中一个具有价值是,Rosetta Flex软件在其他HPC集群上的内存限制为每个节点12或16个同时计算,但Mammoth可以在一个节点上同时处理128次Rosetta Flex计算。

Lawrence Livermore并没有透露Mammoth的具体成本。

/5

/5