什么是GPT-4?

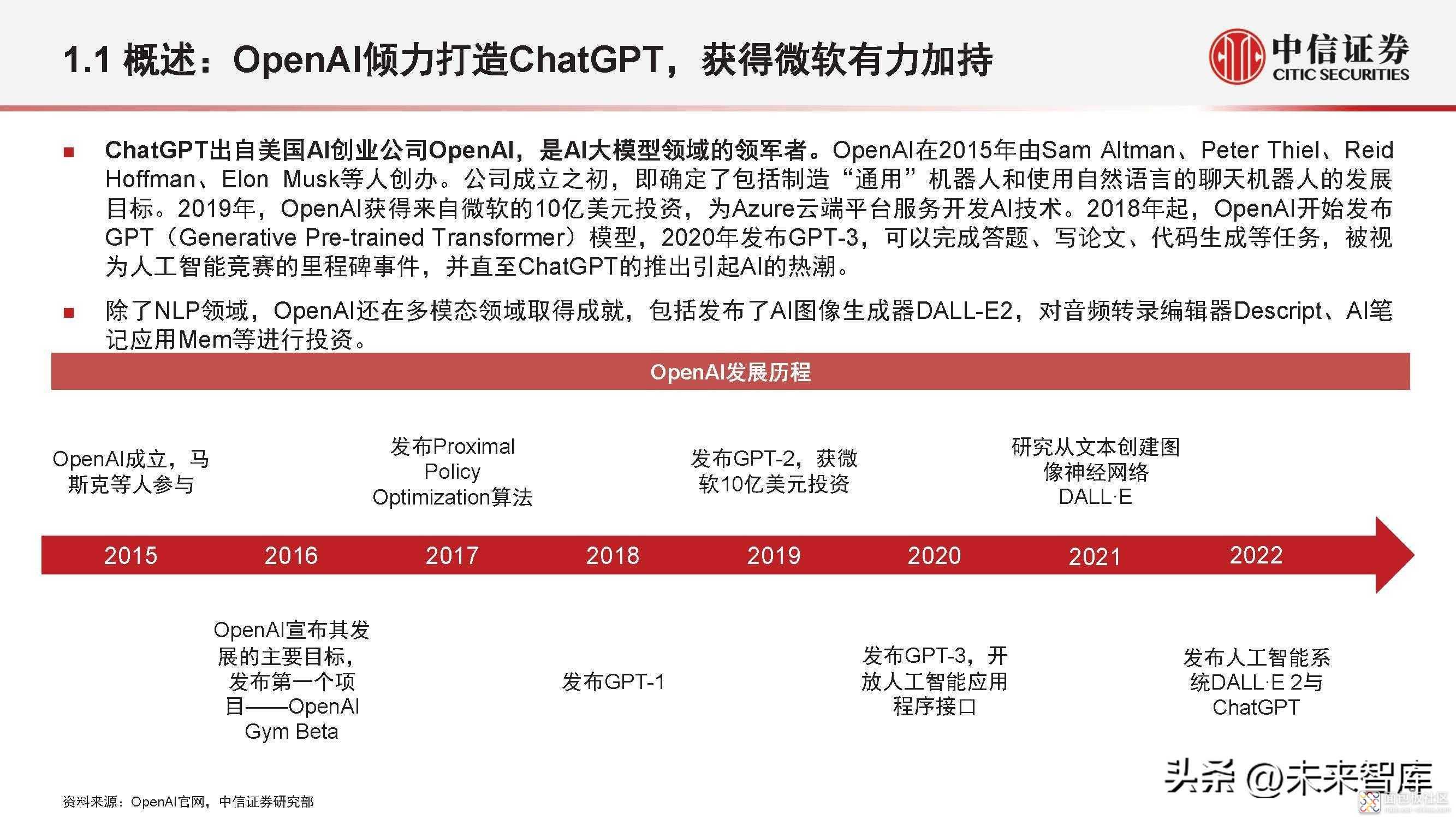

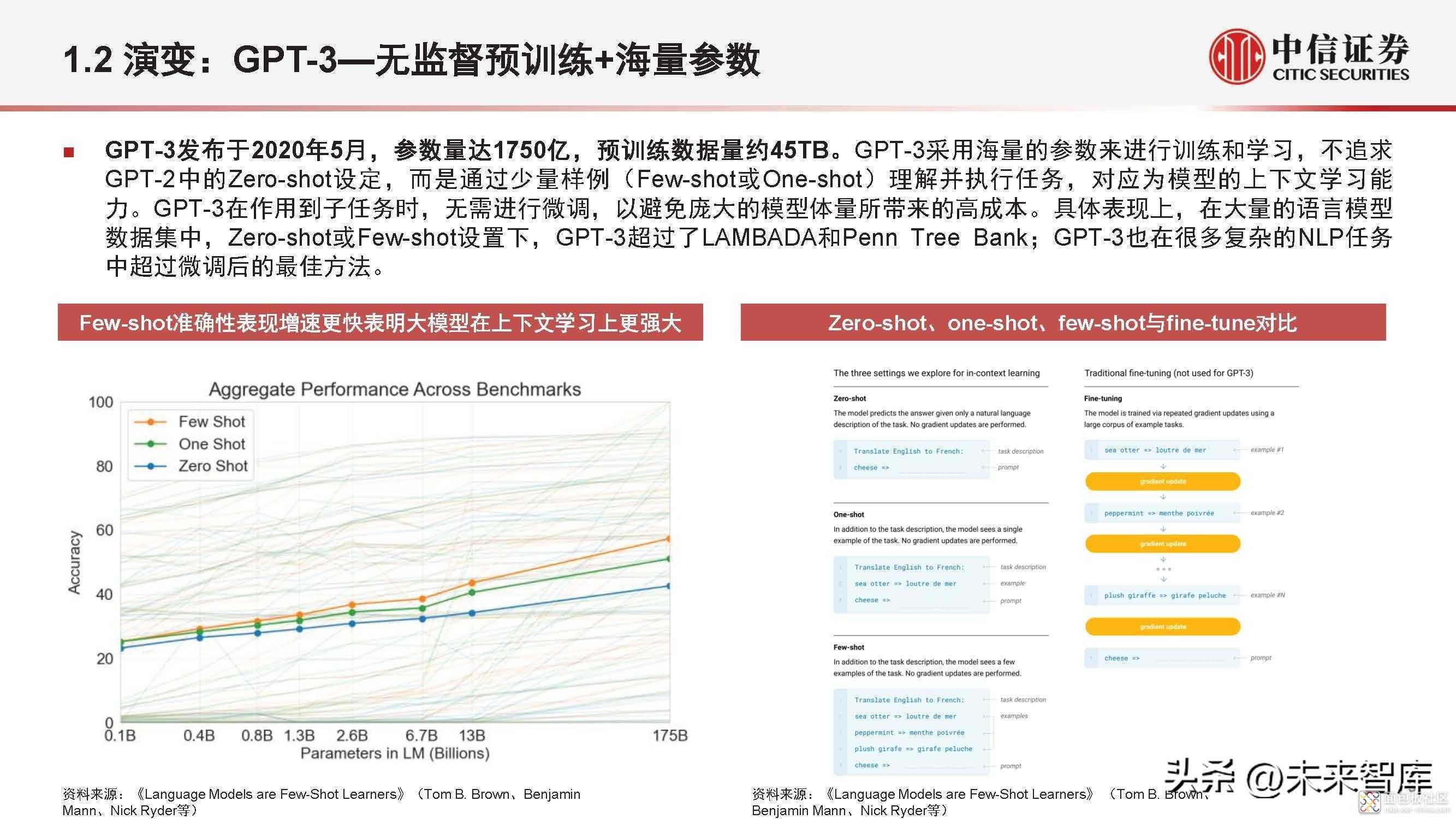

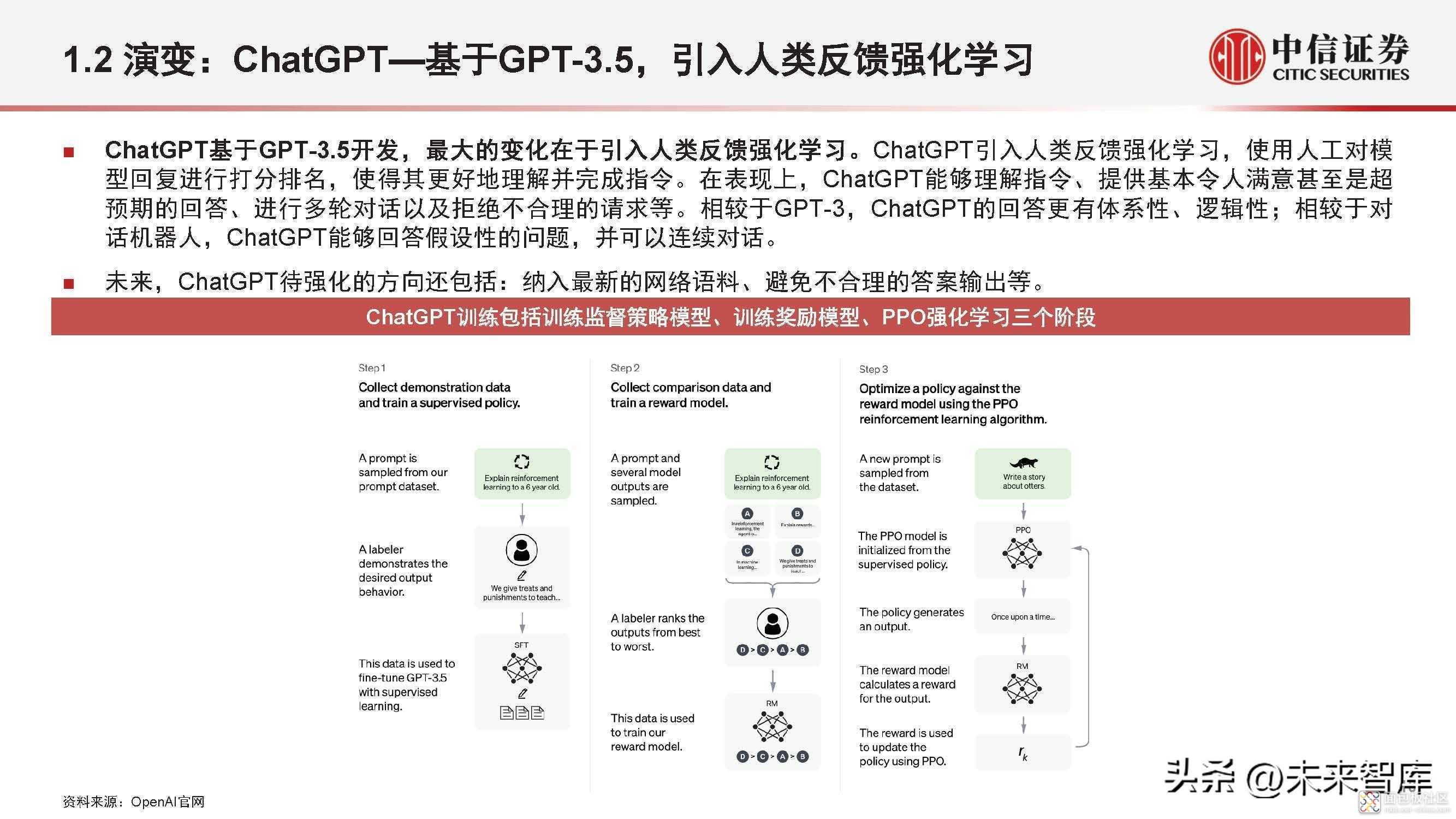

ChatGPT出自美国AI创业公司OpenAI,是AI大模型领域的领军者。2018年起,OpenAI开始发布 GPT(Generative Pre-trained Transformer)模型,2020年发布GPT-3,可以完成答题、写论文、代码生成等任务,被视 为人工智能竞赛的里程碑事件,并直至ChatGPT的推出引起AI的热潮。

GPT-4 模型是第四代大型语言模型(LLM),其最大亮点:不仅可以将文本转化成相应的图像、音乐甚至是视频。

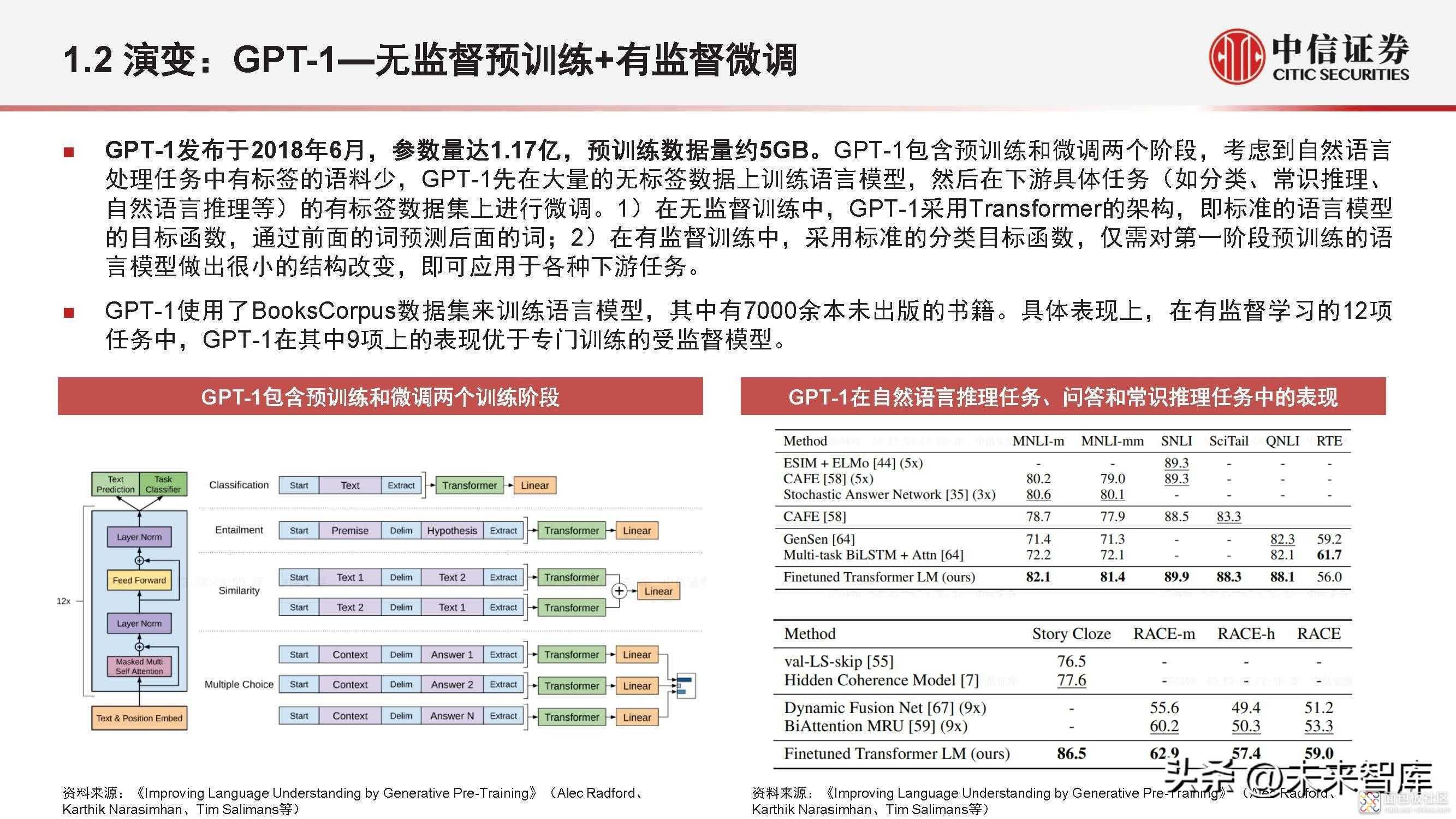

演变:GPT-1—无监督预训练+有监督微调

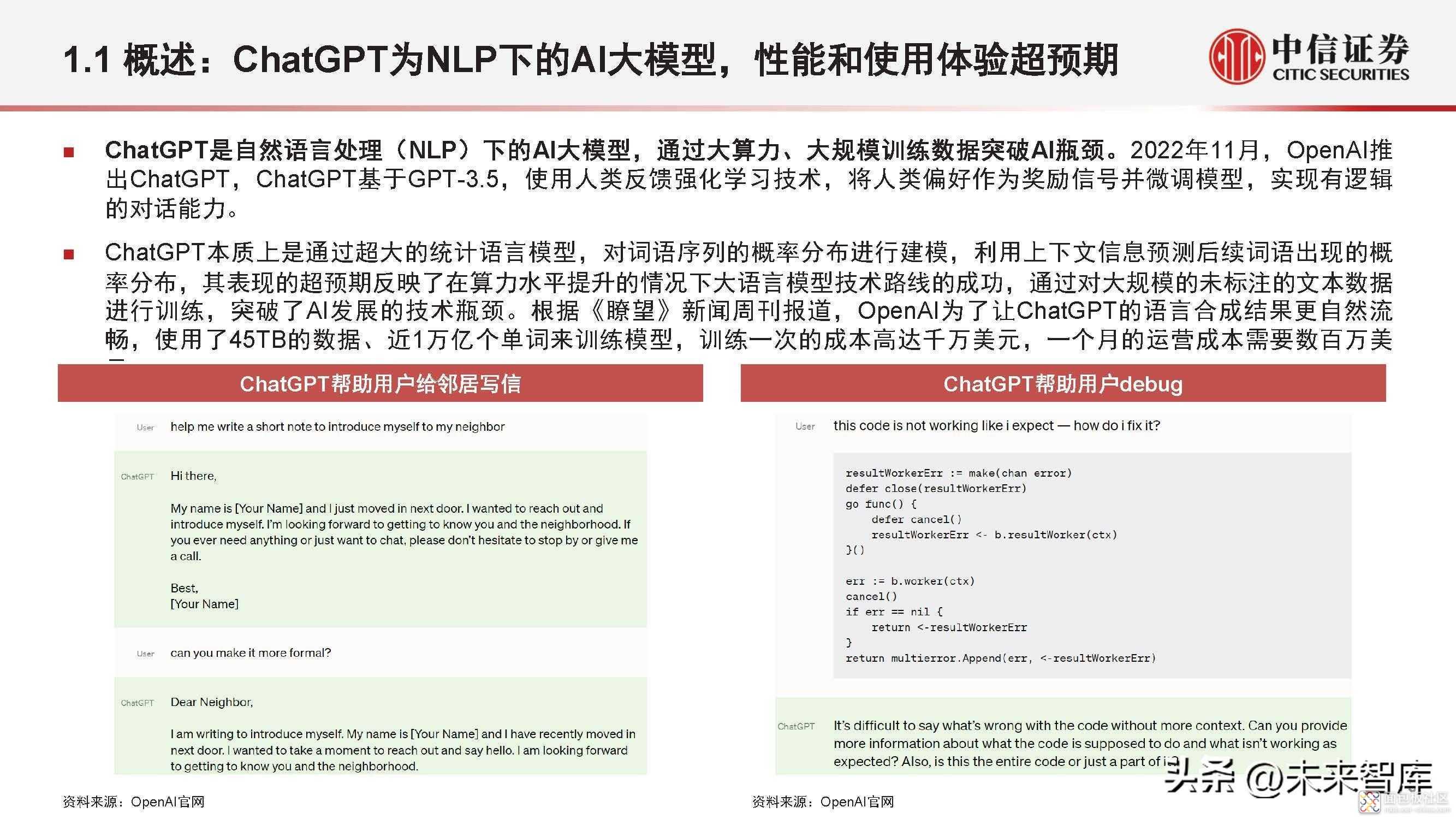

GPT-1发布于2018年6月,参数量达1.17亿,预训练数据量约5GB。GPT-1包含预训练和微调两个阶段,考虑到自然语言 处理任务中有标签的语料少,GPT-1先在大量的无标签数据上训练语言模型,然后在下游具体任务(如分类、常识推理、 自然语言推理等)的有标签数据集上进行微调。1)在无监督训练中,GPT-1采用Transformer的架构,即标准的语言模型 的目标函数,通过前面的词预测后面的词;2)在有监督训练中,采用标准的分类目标函数,仅需对第一阶段预训练的语 言模型做出很小的结构改变,即可应用于各种下游任务。

GPT-1使用了BooksCorpus数据集来训练语言模型,其中有7000余本未出版的书籍。具体表现上,在有监督学习的12项 任务中,GPT-1在其中9项上的表现优于专门训练的受监督模型。

演变:GPT-2—无监督预训练+多任务学习

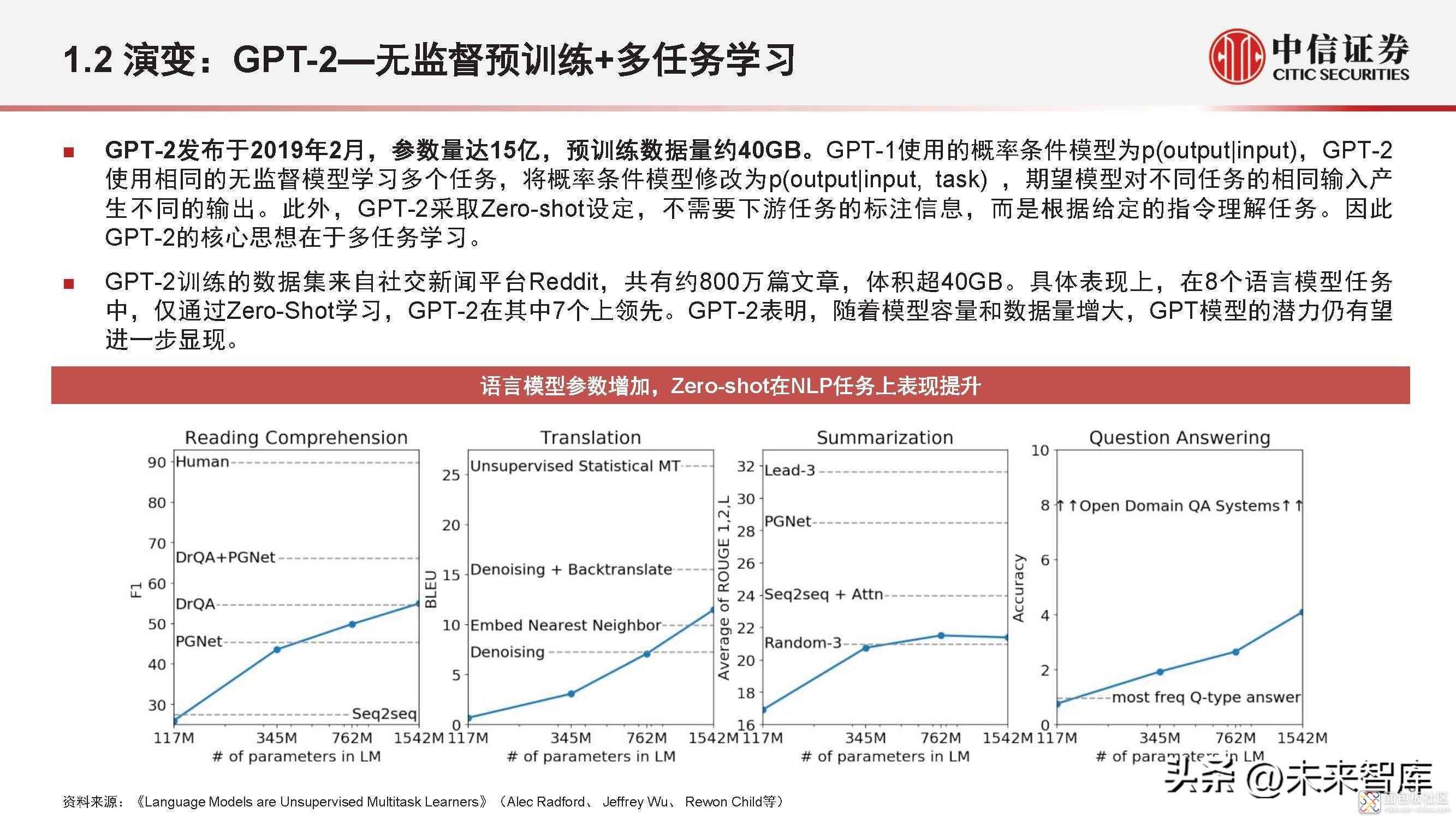

GPT-2发布于2019年2月,参数量达15亿,预训练数据量约40GB。GPT-1使用的概率条件模型为p(output|input),GPT-2 使用相同的无监督模型学习多个任务,将概率条件模型修改为p(output|input, task) ,期望模型对不同任务的相同输入产 生不同的输出。此外,GPT-2采取Zero-shot设定,不需要下游任务的标注信息,而是根据给定的指令理解任务。因此 GPT-2的核心思想在于多任务学习。

GPT-2训练的数据集来自社交新闻平台Reddit,共有约800万篇文章,体积超40GB。具体表现上,在8个语言模型任务 中,仅通过Zero-Shot学习,GPT-2在其中7个上领先。GPT-2表明,随着模型容量和数据量增大,GPT模型的潜力仍有望 进一步显现。

展望:GPT-4—此前外界预期参数量变化不大、使用门槛有望降低

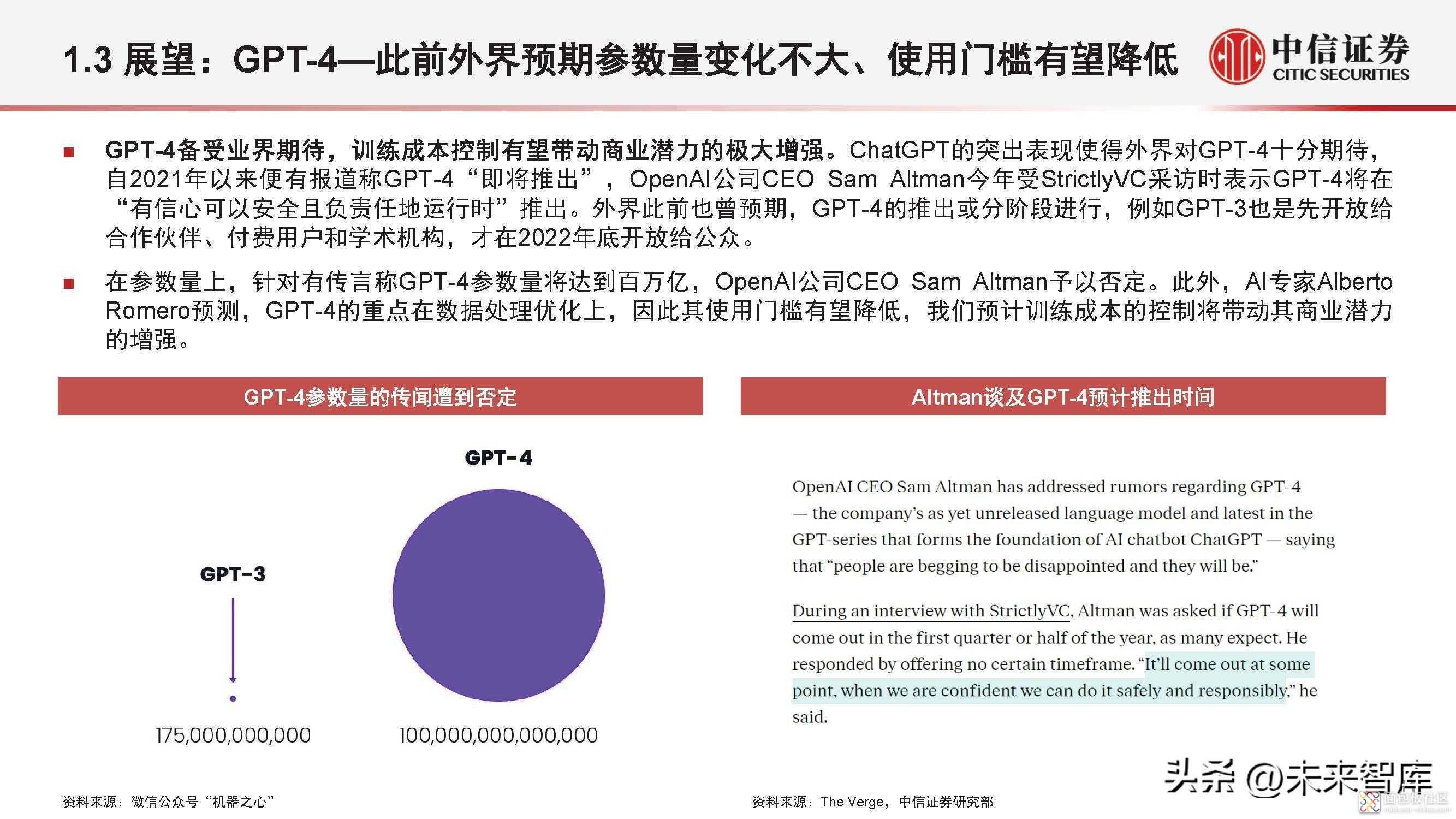

GPT-4备受业界期待,训练成本控制有望带动商业潜力的极大增强。ChatGPT的突出表现使得外界对GPT-4十分期待, 自2021年以来便有报道称GPT-4“即将推出” ,OpenAI公司CEO Sam Altman今年受StrictlyVC采访时表示GPT-4将在 “有信心可以安全且负责任地运行时”推出。外界此前也曾预期,GPT-4的推出或分阶段进行,例如GPT-3也是先开放给 合作伙伴、付费用户和学术机构,才在2022年底开放给公众。

在参数量上,针对有传言称GPT-4参数量将达到百万亿,OpenAI公司CEO Sam Altman予以否定。此外,AI专家Alberto Romero预测,GPT-4的重点在数据处理优化上,因此其使用门槛有望降低,我们预计训练成本的控制将带动其商业潜力 的增强。

展望:GPT-4—最新消息称推出在即、支持多模态

最新消息称GPT-4将于下周推出,支持多模态应用,开启通往人工通用智能之路。根据德国科技媒体“heise在线”报 道,当地时间3月9日,微软德国公司首席技术官Andreas Braun在名为“AI in Focus - Digital Kickoff”的活动中透露称 “将在下周推出GPT-4,它将是一个多模态模型,会提供完全不同的可能性——例如视频”。这意味着GPT-4可以管理不 同语言数据的输入和输出,也能够做到输出图像甚至视频。在活动上,微软AI技术专家对多模态AI的应用案例进行了介 绍,例如能够将电话呼叫的语音直接记录成文本,这为微软位于荷兰的一家大型客户节省500个工作小时/天。

GPT-4对多模态的支持使得外界对模型潜力的预期进一步强化,原因在于多模态感知是建立人工通用智能(AGI)的重要 一步,基于此能够执行人类水平的一般任务。

(报告出品方:中信证券)

来源:未来智库

/3

/3